🎭 让照片开口说话:腾讯AniPortrait用AI生成逼真肖像动画

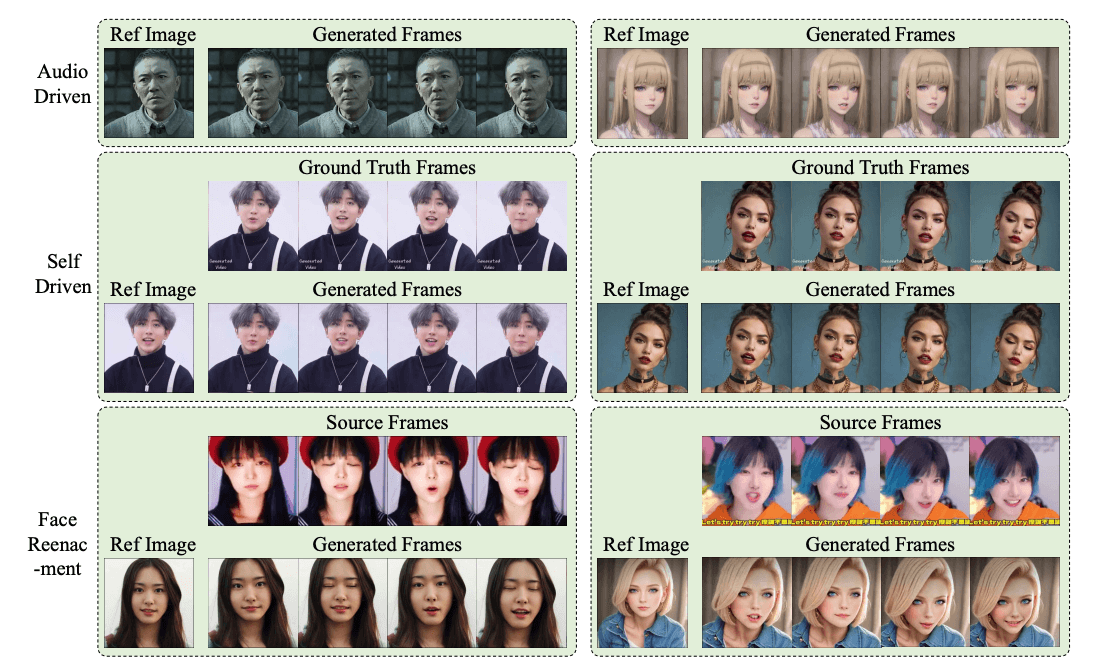

想让静态照片里的人开口唱歌、说话甚至做表情?腾讯AI实验室推出的AniPortrait开源框架,只需一段音频和一张人脸图片,就能生成高质量、口型同步的动态肖像视频。这项技术不仅让虚拟形象活起来,更为游戏、短视频创作甚至虚拟现实带来了新的可能。

核心功能:AI如何让人脸“动”起来?

AniPortrait的核心能力是将音频驱动与图像动画完美结合。它不仅仅对口型,还能生成丰富的面部表情和自然的头部动作。

- 音频驱动面部动画:输入一段语音,AI能自动生成与之匹配的唇动、表情和头部微动作,同步率极高。

- 高逼真度输出:生成的视频细节丰富,肤色、光影过渡自然,肉眼难以分辨是AI生成还是真实拍摄。

- 保持时间一致性:确保生成的动画帧之间流畅衔接,避免出现脸部闪烁或扭曲的跳帧现象。

- 支持灵活控制:允许用户干预和调整生成的3D面部网格,自定义特定的表情或头部姿势。

- 高效推理性能:对模型进行了优化,在保持质量的同时,尽可能减少计算资源消耗和生成时间。

工作原理

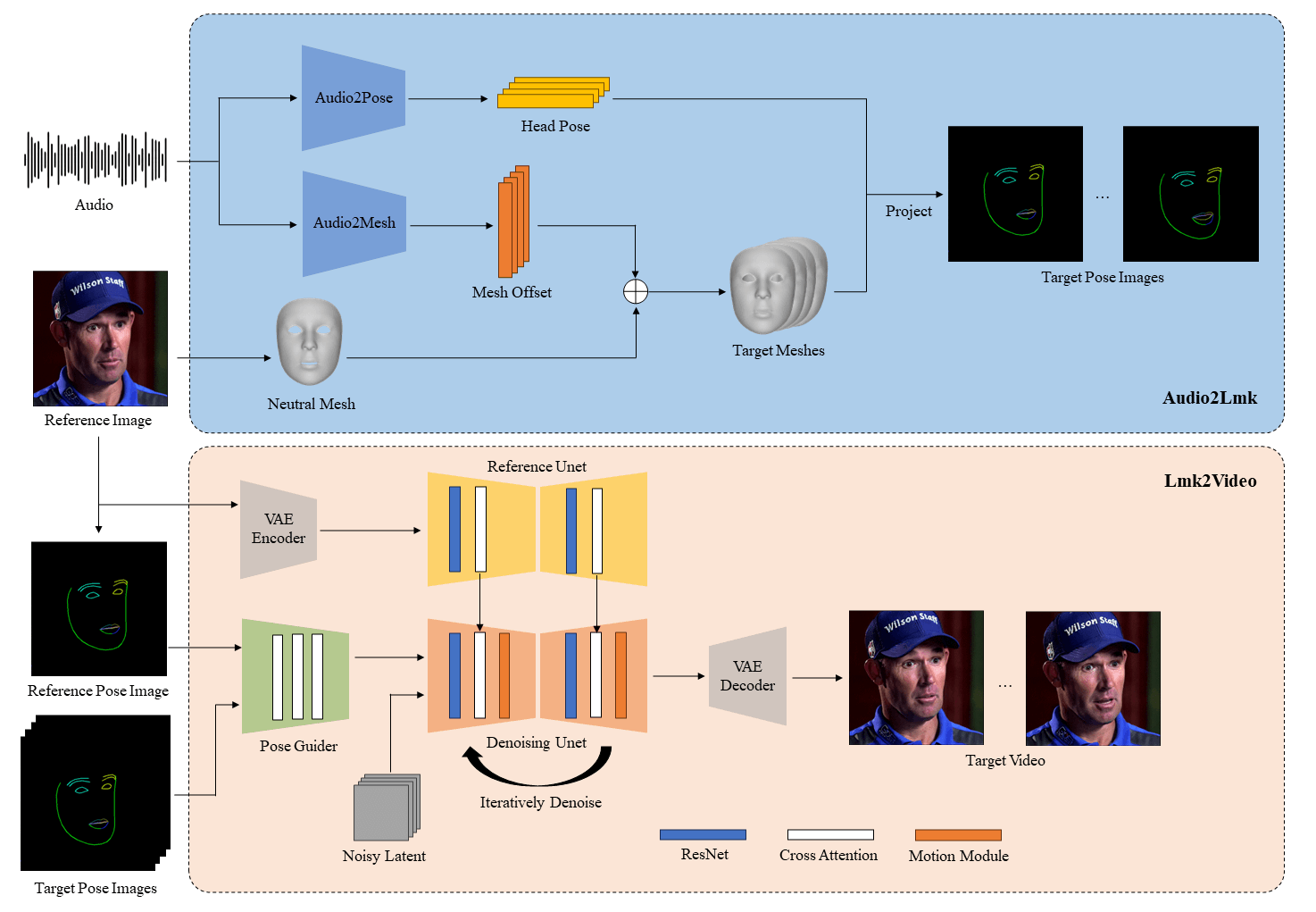

AniPortrait的工作流程可以简单理解为“听懂声音-构建模型-画出动画”。

- 音频处理与特征提取:首先,使用wav2vec等模型“听懂”音频,分析出说话的语调、节奏和停顿等特征。

- 3D面部建模:根据输入的人脸图像,AI会估算并生成一个3D人脸模型,精准捕捉五官结构和潜在的表情变化。

- 动画生成与渲染:将音频特征和3D模型信息转化为2D的面部特征点,然后借助类似Stable Diffusion的扩散模型,逐步“画”出每一帧高清视频,并通过PoseGuider等模块精细调整,确保唇动绝对精准。

应用场景

- 游戏开发者:快速为游戏内的NPC(非玩家角色)生成与台词同步的面部动画,大幅提升游戏沉浸感和制作效率。

- 短视频与社交媒体创作者:为自己或原创IP形象制作有趣的开口唱歌、讲段子的视频,轻松获取流量。

- 虚拟现实(VR)与元宇宙:为虚拟化身(Avatar)注入灵魂,赋予其逼真的面部表情和互动能力,提升体验真实感。

- 数字媒体与广告行业:以更低成本、更高效率为广告、短片或电影制作高质量的数字人动画内容。

- 教育与培训:制作语言学习视频或表情识别培训材料,让教学内容更加生动直观。

AniPortrait深度评测与竞品对比

👍 优点

- 开源免费:代码完全公开,研究和开发者可自由使用、修改和分发,学习和定制成本低。

- 效果出众:在唇音同步(Lip-sync)和自然表情生成方面表现出色,效果处于行业前沿水平。

- 灵活性高:不仅支持音频驱动,还允许通过参考视频等方式生成动画,应用场景广泛。

👎 缺点

- 硬件门槛高:模型推理对显卡要求苛刻,推荐使用NVIDIA RTX 3090及以上性能的GPU,普通用户电脑很难流畅运行。

- 依赖输入质量:如果输入的音频嘈杂或人脸图片模糊、角度刁钻,生成效果会大打折扣,可能出现口型对不上或脸部扭曲。

- 上手有难度:作为开源框架,它需要通过代码命令行操作,缺乏图形化界面,对非技术用户极不友好。

🔍 2025年主要竞品对比

在音频驱动人脸动画领域,AniPortrait面临几个强劲对手。它们各有侧重,满足不同用户的需求。

| 产品 | 核心定位与差异 | 优缺点 |

|---|---|---|

| AniPortrait | 开源框架,强在音频驱动全面部动画(唇动+表情+头部姿势) | ✅ 效果逼真、免费可定制;❌ 硬件要求高、需技术背景 |

| Wav2Lip | 专注唇动同步的轻量级模型,堪称“对口型神器” | ✅ 速度快、资源占用少、易集成;❌ 基本只处理嘴唇,忽略面部其他表情 |

| SadTalker | 同样开源,支持生成带有头部姿势和眼神运动的动画 | ✅ 生成动作更丰富;❌ 整体自然度和唇部精度略逊于AniPortrait |

| HeyGen / Synthesia | 成熟的商业数字人平台,提供一站式Avatar视频制作服务 | ✅ UI直观、效果稳定、开箱即用;❌ 付费昂贵、自定义能力弱 |

| Adobe Character Animator | 绑定Adobe生态的专业动画软件,支持实时捕捉和驱动 | ✅ 与PS/AE无缝衔接、实时控制;❌ 学习曲线陡峭、订阅费用高 |

💡 选择建议:

- 如果你是研究者、开发者,追求最佳效果且不惧折腾,AniPortrait是顶级开源选择。

- 如果只想快速给视频对口型,Wav2Lip更简单高效。

- 如果追求商业级的稳定性和易用性,且预算充足,HeyGen等商业平台是更好选择。

💎 总结

hello123小评:AniPortrait让我们看到了一个未来:任何人都能低成本地赋予静态形象以动态生命,讲述更生动的故事。虽然目前它仍主要活跃在实验室和开发者圈子,但其开源和前沿性无疑为整个行业树立了标杆。技术的最终归宿是融入生活,或许不久后,我们制作一个自己的数字分身,就会像美颜拍照一样简单。