2025谷歌AudioPaLM全面评测:一个模型搞定语音识别+翻译+合成,实时保留原声不违和!对比Whisper/MMS三大竞品优劣势,附使用技巧与避坑指南。想知道如何实现无缝跨语言交流?立即查看详解!

AudioPaLM:谷歌打造的“能听会说”的AI助手,语音翻译不留痕

还记得那些科幻电影里不同星球的人用个小设备就能实时对话的场景吗?人工智能正在把这种想象变成现实。谷歌在2023年推出的AudioPaLM大型语言模型,就是一个能同时理解和处理语音与文本的多模态AI系统,让我们向无缝跨语言交流又迈进了一大步。

- 论文:https://huggingface.co/papers/2306.12925

- 演示 demo:https://google-research.github.io/seanet/audiopalm/examples/

演示视频:

核心功能一览

AudioPaLM的设计目标是成为一个全面的语音AI助手,其主要能力包括:

- 语音识别(ASR):将语音转换为文本。

- 语音合成(TTS):将文本转换为语音。

- 语音翻译:不仅能将语音翻译成另一种语言的文本,甚至能直接输出翻译后的语音,并尽可能保留原始说话人的声音特色。

- 跨语言声音迁移:仅凭一段简短的外语语音提示,模型就能模仿该声音说其他语言。

技术基石:融合文本与语音的“大脑”

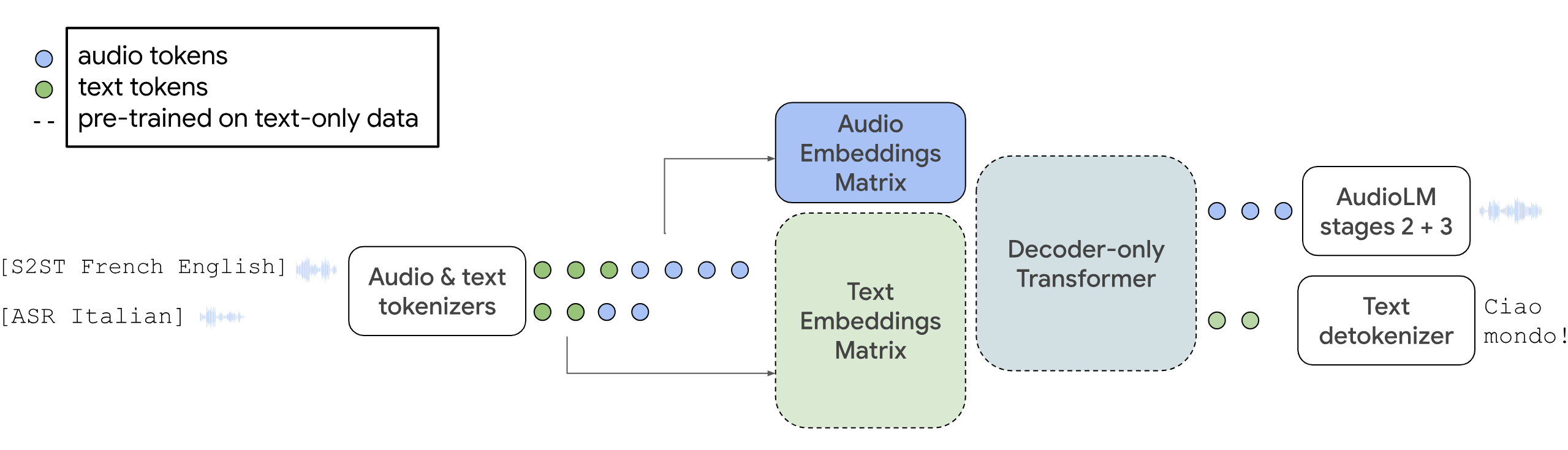

AudioPaLM的强大,源于其巧妙地将谷歌两大模型的优势合二为一:PaLM-2的大型语言模型能力和AudioLM的语音处理与生成能力。这使得它不仅能像ChatGPT那样理解和生成文本,还能处理音频信息。

其关键技术在于一个统一的词汇表,它能将文本和语音都用一种叫做“token”的离散单元来表示。简单理解,它学会了一种同时包含“文字符号”和“声音符号”的通用语言。这使得单一的Transformer模型能够处理交织混合的语音和文本任务。

更聪明的是,研究人员通过扩展已有纯文本大模型(如PaLM)的嵌入层来创建AudioPaLM,而非从头训练。这相当于让一个语言学霸快速学会了听力与口语,高效利用了海量的文本知识来辅助语音任务。

实际表现如何?

根据谷歌的研究论文和示例,AudioPaLM展现出色:

- 在语音翻译任务上,其性能显著优于当时的其他系统(如OpenAI的Whisper),在自动语音识别(ASR)任务上也具有竞争力。

- 零样本迁移能力是亮点。即使遇到训练时从未见过的语音输入和目标语言组合,它也能尝试进行翻译,这对于支持小众语言意义重大。

- 能保留“说话人特征”。在语音到语音翻译时,它生成的语音在质量和与原始说话人声音的相似度上,均优于之前的基线系统(如Translatotron 2)。这意味着你说着中文,AI帮你转换成英语后,听起来可能还是“你”在说,而不是一个冰冷的机器声音。

工作原理一瞥

- 信息输入与编码:AudioPaLM的输入可以是文本或音频。音频会被一个表征模型(如w2v-BERT或USM)转换为嵌入向量,再经量化产生离散的音频token。

- 统一处理:文本token和音频token被合并成一个序列,前面加上特定任务标签(如

[S2ST English French]表示英到法语音翻译),然后送入解码器-only的Transformer模型进行处理。 - 信息输出与解码:模型根据任务输出相应的文本或音频token序列。若输出是音频token,会再通过诸如SoundStorm之类的解码器转换为最终的音频波形。

AudioPaLM深度评测与竞品对比

👍 核心优点

- 功能高度集成:一个模型搞定多种语音文本任务,省去了过去需要串联多个专用模型的麻烦。

- 上下文与语义理解更强:依托PaLM-2的语言能力,在翻译时更能把握语义精髓,进行地道的意译而非生硬直译。

- 出色的零样本学习能力:对未在训练中明确出现的语言对展现出了一定的泛化能力。

- 语音保真度较高:在语音转换中能较好地保留说话人身份和语调等副语言信息。

👎 主要缺点

- 基准测试并非全能冠军:虽然在语音翻译上领先,但在纯语音识别(ASR)等任务上,其性能当时仅与其它顶级模型“竞争”而非绝对领先。

- 音频生成基准仍待完善:研究团队指出,相较于文本,音频生成任务的评估基准和指标生态仍不够成熟,这在一定程度上影响了更全面的评估。

- 处理能力或有局限:模型训练时处理的语音条件样本长度约为3秒,对于长音频的处理可能需要额外设计。

🥊 与主要竞品对比

2025年,多模态语音AI领域竞争激烈。AudioPaLM面临的主要竞品有:

| 特性维度 | AudioPaLM (Google) | Whisper (OpenAI) | MMS (Meta) |

|---|---|---|---|

| 核心架构 | 融合文本与语音的单一Decoder-Only Transformer | 编码器-解码器 Transformer | 基于wav2vec 2.0 |

| 主要功能 | 语音识别、合成、翻译(文本&语音输出)、跨语言声音克隆 | 语音识别、翻译(文本输出) | 语音识别、合成(支持超多语言) |

| 2023年所示语言支持 | 百余种语言 | 97种语言 | 1100+种语言 |

| 独特优势 | 功能集成度高,语音翻译保留音色,零样本迁移能力强 | 知名度高,广泛集成与应用 | 语言覆盖范围极广,专注于语音识别与合成的广度 |

| 潜在局限 | 音频生成评估体系较新,ASR性能非最强项 | 主要输出文本,不直接生成语音,无法保留原说话人声音 | 功能聚焦,不直接处理跨模态联合任务(如语音到语音翻译) |

简要总结:

- AudioPaLM的优势在于其多功能的集成性和在语音翻译中保留说话人特征的能力,适合需要高质量、沉浸式跨语言通信的场景。

- OpenAI的Whisper更像是一个准确的“转录员”,长于将语音转为文本,但后续步骤需其他工具配合。

- Meta的MMS则像是“语言博物馆”,在覆盖语言的广度上无与伦比,尤其关注那些资源稀缺的语言。

选择哪款工具,取决于你的具体需求:是追求极致的翻译和沉浸体验,是只需准确的文字记录,还是要处理非常小众的语言。

高效使用技巧

- 提供清晰的任务指令:在输入前使用如

[ASR French](法语语音识别)、[TTS English](英语语音合成)或[S2ST English French](英到法语语音翻译)等标签明确任务,能引导模型产生更准确的输出。 - 利用语音提示:若希望翻译后的语音保留特定说话人的声音,可以提供该说话人短短几秒的语音作为提示。

- 关注音频质量:输入高质量的音频通常能获得更好的处理结果。模型在训练时也对极低质量音频进行了过滤。

人工智能正在打破语言的壁垒,让世界变得更“小”。AudioPaLM这类多模态模型的出现,预示着一个未来:我们与设备的交互将更自然,人与人之间的沟通将更无碍,信息的获取与创造将更自由。下一次语言不通时,帮你实时沟通的,或许就是一个像AudioPaLM这样安静而强大的AI。