效率革命:DeepSeek-V3.2用稀疏注意力重塑长文本处理

面对长文档不再卡顿,AI模型正在掀起一场效率革命。

9月29日,DeepSeek正式发布实验性版本V3.2-Exp模型,该版本在V3.1-Terminus基础上引入DeepSeek Sparse Attention(DSA)稀疏注意力机制,针对长文本训练和推理效率进行了优化。

官方表示,DSA首次实现细粒度稀疏注意力机制,在几乎不影响模型效果的前提下大幅提升效率。

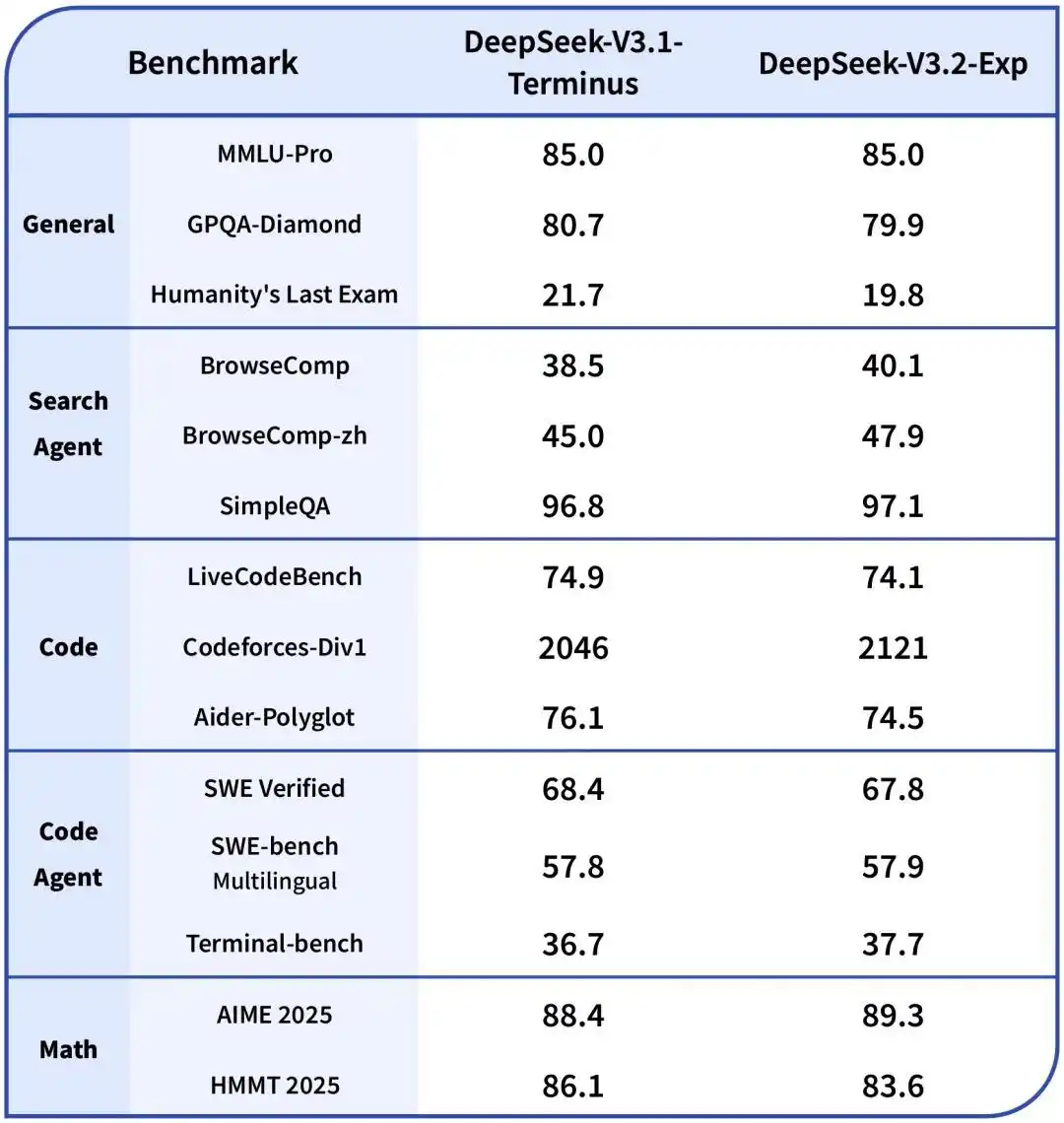

目前官方App、网页端和小程序均已更新至V3.2-Exp版本,为严谨评估改进效果,该版本训练设置与V3.1-Terminus保持严格对齐,评测表现基本持平。

- HuggingFace模型库:https://huggingface.co/deepseek-ai/DeepSeek-V3.2-Exp

- 魔搭社区:https://modelscope.cn/models/deepseek-ai/DeepSeek-V3.2-Exp

- 技术论文:https://github.com/deepseek-ai/DeepSeek-V3.2-Exp/blob/main/DeepSeek_V3_2.pdf

一分钟速览版

- 核心创新:引入DeepSeek Sparse Attention(DSA,稀疏注意力),专为长文本优化

- 效率表现:在64k序列长度下,前向传播速度提升可达9倍,反向传播实现6倍加速,呈现出“越长越优”的趋势

- 技术根源:DeepSeek稀疏注意力的核心思想,正是来源于北京大学与DeepSeek团队合作那篇荣获ACL 2025最佳论文的突破性研究——原生稀疏注意力机制

- 价格变动:API价格大幅下降,降低开发者使用成本

- 开源信息:模型已在Huggingface与魔搭平台全面开源

背后的黑科技:稀疏注意力

那么,DSA到底是如何工作的?

它的核心是一个叫做“闪电索引器”的高效组件。这个索引器能快速判断对于当前正在处理的词,历史上下文中的哪些部分是最重要的。

随后,模型只从这些重要部分中选取一小部分(例如2048个)进行精细计算。如此一来,核心注意力的计算复杂度就从O(L²)骤降至O(Lk),其中k是一个远小于L的固定值。

更聪明的是,这种效率提升并非以牺牲性能为代价。

团队先用一个简短的 “密集预热” 阶段来初始化闪电索引器,让它学会模仿原有模型的注意力分布,然后再进入 “稀疏训练” 阶段,让整个模型适应新的稀疏模式。

评估结果显示,无论是在短文本还是长文本任务上,DeepSeek-V3.2-Exp的性能与它的“密集注意力”前身V3.1-Terminus相比,都没有出现实质性的性能下降。

这项技术并非凭空而来,它基于北京大学与DeepSeek合作的原生稀疏注意力(NSA)研究,该成果刚在ACL 2025上荣获最佳论文奖,并已被DeepSeek、华为、字节跳动等多家领先的大模型企业实现或复现。

来的直接好处是计算复杂度从O(L²)优化至O(Lk),其中L是序列长度,k是常数。意味着处理越长文本,效率优势越明显。

价格大幅下调

得益于新模型服务成本的大幅降低,DeepSeek再一次把模型价格打了下来。

官方API价格也相应下调,降低50%以上。对于正在使用DeepSeek API的开发者来说,这无疑是个实实在在的利好。

目前API的模型版本已更新为DeepSeek-V3.2-Exp,访问方式保持不变。无论是通过官方App、网页端还是小程序,用户都能体验到新模型带来的效率提升。

如何使用:多种方式轻松体验

对于开发者而言,体验这一技术突破有多种途径:

- 官方应用:DeepSeek的官方App、网页端和小程序均已更新至V3.2-Exp版本,普通用户可以直接使用,无需任何技术背景。

- API接入:DeepSeek-V3.2-Exp的API价格大幅下降,显著降低了开发者的使用成本。为方便对比,官方临时保留V3.1-Terminus的API接口。

- 本地部署:模型已在Huggingface与魔搭平台开源,相关论文也已同步公开,研究人员和开发者可以下载模型权重进行本地部署和深入研究。

应用场景:

这一技术突破为多个应用场景带来新的可能:

- 长篇文档分析:处理技术文档、法律合同、学术论文等长文本时,不再受长度限制,可以保持完整的上下文理解。

- 智能信息检索:结合像阿里WebDancer这样的信息检索代理,能够更高效地进行多步推理和网页遍历,实现自主信息搜索。

- 代码开发与分析:轻松处理大型代码库,正如Qwen Code等编程助手展示的能力,实现对整个代码库的深度理解和交互。

- 学术研究:该技术本身也值得深入研究,NSA机制的实现细节和理论基础为后续算法优化提供了宝贵参考。

随着企业面临的数据量不断增长,处理长文档、代码库和多步骤推理任务的需求日益迫切。DeepSeek-V3.2-Exp代表的稀疏注意力技术,正在为AI处理长文本打开新的可能性。

无论是阅读百页报告、分析大型代码库,还是进行复杂的研究任务,效率提升都意味着我们可以让AI承担更复杂的认知工作。