🚀 Dify:不懂代码也能玩转AI应用开发

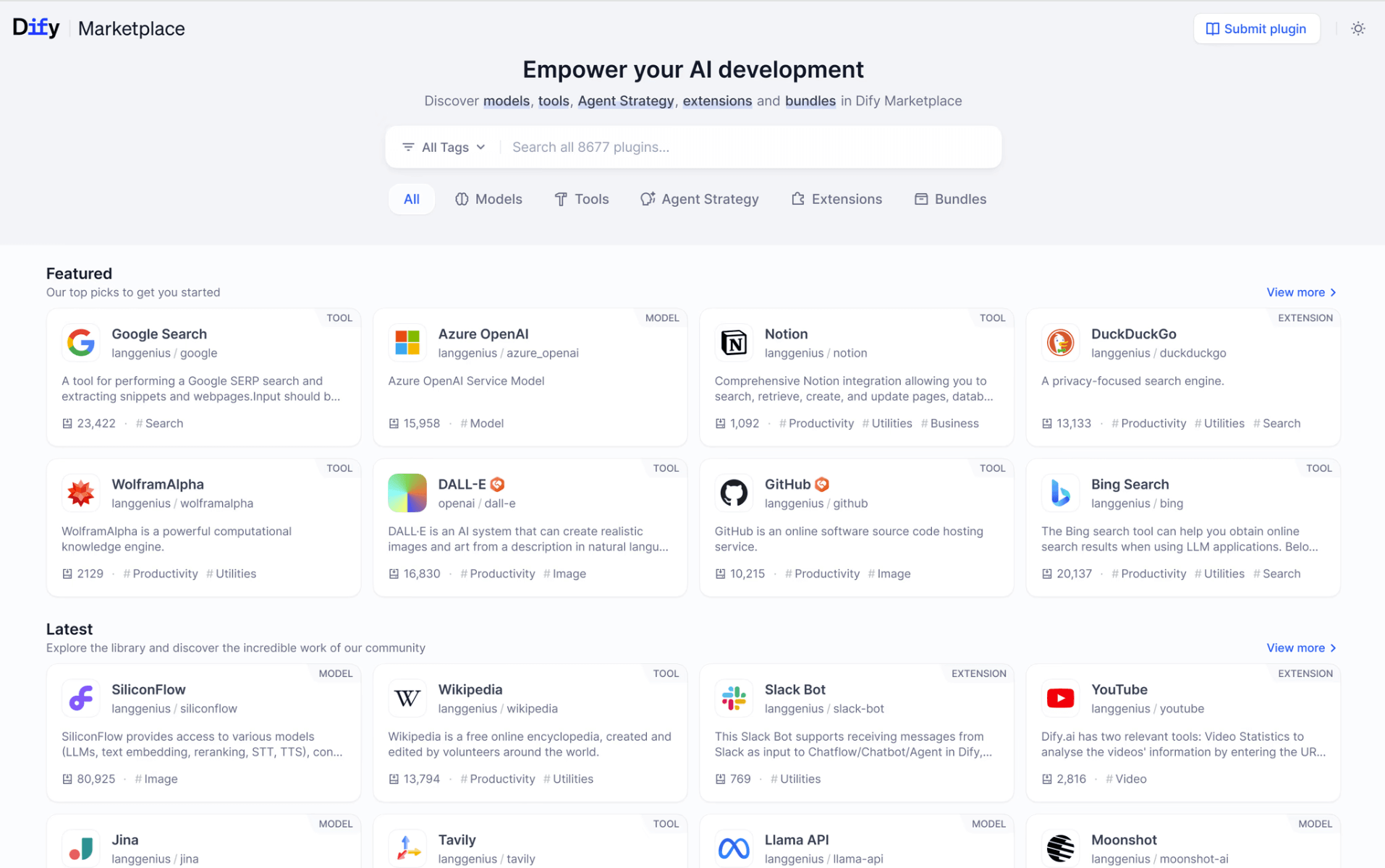

想开发AI应用但被技术门槛劝退?Dify这个开源大语言模型开发平台,让搭建AI应用变得像搭积木一样简单。它深度融合LLMOps理念和可视化编排能力,集成数百种主流AI模型,提供从提示词设计到部署运营的全套工具,大幅降低企业级AI应用开发门槛,让你零代码也能构建智能客服、办公助手等实用应用。

核心功能:可视化打造AI应用

Dify让AI应用开发变得简单高效:

- 智能体与工作流引擎:通过拖拽式界面设计半自主智能体,集成50多种预置工具;支持循环节点与嵌套逻辑,电商订单处理效率提升3倍。

- 知识库增强系统:能解析PDF、PPT等文档中的图文内容,检索准确率达92%;混合搜索技术让金融合同检索效率提升40%。

- 企业级安全部署:支持本地数据库隔离与OAuth 2.0认证,满足等保三级合规要求;动态资源管控防止系统过载。

- 全模型生态集成:无缝切换OpenAI、Azure、通义千问等20多家厂商模型,适配不同成本和性能需求。

应用场景

Dify在多个业务场景中都能发挥巨大价值:

- 智能客服系统:3分钟接入业务知识库,自动生成带图文回复的客服机器人;支持动态参数调整,对话中实时修改生成长度和语气。

- 自动化办公助手:处理无限长文档总结重组,将万字合同压缩至千字保留核心条款;支持多语言文档处理,满足国际化需求。

- 垂直领域Agent:电商物流Agent自动处理订单和物流通知,降低60%人力成本;法律检索Agent实现百万级条文索引,准确率达92%。

快速入门

使用Dify非常简单:

- 环境准备:注册即获免费额度,或Docker Compose一键安装本地部署。

- 选择应用类型:根据需求选择对话型、文本生成型或助手型应用。

- 配置知识库:上传文档,选择清洗模式,关联上下文。

- 发布集成:复制Script标签至官网生成AI客服,或通过API对接企业系统。

开发技巧:先用预置模板快速验证想法,再逐步自定义优化,效率更高。

Dify深度评测与竞品对比

✅ 核心优点:

- 开发效率极高:工作流循环节点将批量任务开发时间从天缩短至小时级;可视化Prompt编排界面让模型调试效率提升70%。

- 企业级灵活性:私有部署支持数据完全本地化,成为金融、政务机构首选;Tablestore向量库集成能承载百亿级数据检索。

- 生态开放性好:Apache 2.0协议开源,二次开发自由度高于FastGPT等竞品。

- 应用效果显著:累计支撑超10万开发者构建AI应用,78%企业用户将客服系统部署周期从月压缩至周。

⚠️ 主要缺点:

- 学习曲线陡峭:工作流嵌套逻辑需3-5天熟练,非技术用户上手困难;Agent工具链文档不完善。

- 资源消耗较大:高质量RAG索引消耗大量Token,中小企业可能成本敏感;实时音频处理仅限企业版。

- 社区依赖较强:自定义插件开发依赖社区支持,官方文档更新有时滞后。

🔍 竞品对比

2025年的AI开发平台选择不少,Dify在全功能上优势明显。

| 对比维度 | Dify | FastGPT | ChatWiki |

|---|---|---|---|

| 核心定位 | 全栈开发平台 | 知识库问答 | 企业级AI问答系统 |

| 工作流能力 | 循环节点+嵌套逻辑 | 基础流程编排 | 多步骤任务调度 |

| 模型支持 | 数百家厂商/开源模型 | 主流20+模型 | 20+模型(侧重国产) |

| 部署灵活性 | 云端+SaaS+私有化 | 云服务为主 | 本地数据库存储 |

| 开源协议 | Apache 2.0 | Apache 2.0 | 自定义许可 |

概括来说:

- Dify是全能型选手,优势在于完整的工作流引擎和模型生态,适合复杂业务场景。

- FastGPT更像是“知识库专家”,专注于问答系统的易用性,适合简单应用。

- ChatWiki则走“企业级路线”,侧重国产模型和本地存储,适合特定行业需求。

选择哪款平台取决于你的项目复杂度:要全功能选Dify,要简单问答选FastGPT,要国产化选ChatWiki。

hello123小评:Dify凭借其工作流引擎实现的复杂业务自动化能力确实令人印象深刻,特别是在电商订单循环处理等场景中展现出的效率提升,让AI应用开发从“手工作坊”进入了“工业化生产”时代。其混合搜索架构(向量+关键词+元数据)在金融、法律等高精度场景的表现,显著优于其他方案的GraphRAG方案,这体现了技术在垂直领域深挖的价值。

虽然学习曲线相对陡峭,但一旦掌握就能释放巨大的生产力红利。从累计支撑超10万开发者、78%企业用户大幅缩短部署周期的数据来看,Dify正在成为AI应用开发领域的重要基础设施。这种开源开放的模式不仅降低了技术门槛,更促进了整个生态的繁荣发展。