让照片里的人跳起来:腾讯Follow-Your-Pose-v2,一键让静态图“动”给你看

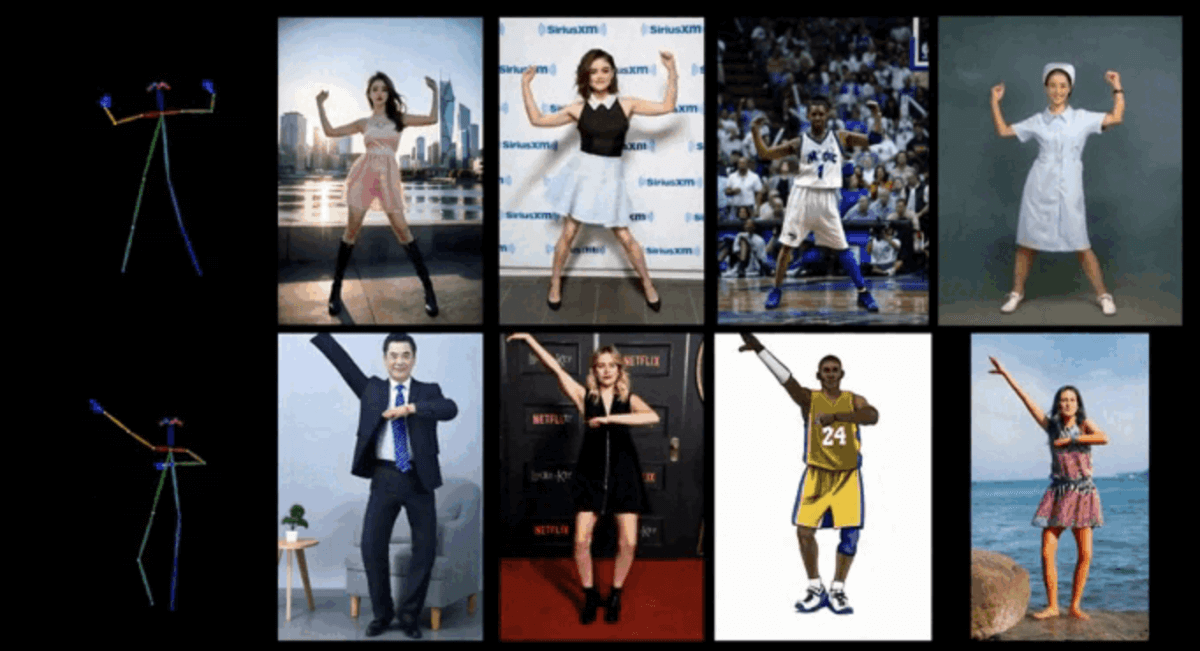

想让你照片里的人物跳起舞来吗?希望让老照片中的家人做出酷炫动作吗?腾讯混元团队联合中山大学、香港科技大学推出的全新图生视频模型Follow-Your-Pose-v2,只需一张人物图片和一段动作视频,就能让静态照片中的人物“活”过来,生成长达10秒的流畅动画。

这项技术不仅在2024年6月发布后引发广泛关注,更因其出色的泛化能力和实用性,为视频创作、广告制作乃至社交媒体内容生产带来了新的可能。无论是复杂背景、多人场景还是特殊着装,它都能处理得游刃有余。

目前官方仅发布了论文,暂未对外开放使用,敬请期待。论文地址:https://arxiv.org/abs/2406.03035

工作原理:让AI理解并复刻动作

Follow-Your-Pose-v2的核心在于其多条件引导机制。它通过“光流指导器”和“深度图指导器”来精准理解人物的空间位置关系,即便在身体遮挡的情况下也能生成合理的前后遮挡画面。

这意味着你只需提供:

- 一张人物图片:可以是任何人、任何年龄、任何着装,甚至背景杂乱也不成问题。

- 一段动作视频:提供想要模仿的动作序列,即使动作复杂也能高质量还原。

模型会智能分析动作视频中的姿态变化,并将其迁移到你提供的人物图片上,输出一段自然流畅的动画视频。

突出优势:不止于“能动”

与一些早期技术相比,Follow-Your-Pose-v2表现出显著优势:

- 支持多人视频动作生成:可以在推理耗时更少的情况下,让画面中的多个人物同时动起来,各做各的动作,互不干扰。

- 强大的泛化能力:无论输入人物是什么年龄、服装,背景如何杂乱,动作视频的动作如何复杂,模型都能努力生成出高质量的视频。

- 处理复杂场景:其设计的多条件引导器,旨在解决背景稳定性、多角色生成中的身体遮挡以及角色外观一致性等挑战。

丰富应用场景:创意不再受限

Follow-Your-Pose-v2的出现,打开了无数创意应用的闸门:

- 社交媒体新玩法:用户可以将自己的静态照片与流行舞蹈动作视频结合,生成个性化的舞蹈短片,轻松在朋友圈或抖音上收获点赞。

- 广告与内容创作:广告行业和社交媒体平台的内容提供者,可以基于此技术快速生成吸引人的视频内容,大幅提升制作效率,降低拍摄成本。

- 影视与游戏预演:动画师和游戏开发者可以使用此模型快速生成或预览角色动画,加速动画制作流程,为前期创意验证提供极大便利。

Follow-Your-Pose-v2深度评测与竞品对比

腾讯Follow-Your-Pose-v2的出现,让图生视频领域受到了更多关注。我们来深入看看它的优缺点,并和市场上的其他玩家做个比较。

优点与缺点

👍 核心优点

- 控制精准,细节到位:模型采用的多条件引导机制(如光流指导器和深度图指导器),旨在让其能够更好地理解人物的空间位置关系,即便在身体遮挡的情况下也努力生成合理的前后遮挡画面,提升了生成视频的逻辑合理性和细节真实感。

- 泛化能力较强:官方信息显示,无论输入人物是什么年龄、服装,背景如何杂乱,动作视频的动作如何复杂,模型都致力于生成高质量的视频,显示了其较强的适应能力。

- 效率与性能平衡:据报道,该模型在推理耗时更少的情况下,支持多人视频动作生成,这在处理多人物场景时是一个优势。

- 视频时长可达10秒:生成视频长度可达10秒,为叙述和展示提供了相对更充裕的时间。

👎 主要缺点

- 体验渠道暂未开放:截至目前,该模型尚未对外开放使用,普通用户和开发者还无法亲自体验其效果,只能通过论文和官方演示了解其能力。

- 面临共同技术挑战:与此类生成式AI模型一样,其生成视频的绝对流畅度、分辨率和完全消除可能存在的微小人工痕迹方面,仍有持续优化的空间。

- “黑箱”疑虑:深度学习模型固有的不可解释性,使得用户可能难以理解模型内部的具体决策过程。

竞品对比

2025年,图生视频及相关人物动画生成领域竞争激烈。Follow-Your-Pose-v2面临一些强劲对手。

| 特性对比 | Follow-Your-Pose-v2 | 深度伪造(Deepfake)类技术 (如FaceSwap等) | 其他T2V/图生视频模型 (如Runway Gen-3, 唯象AI等) |

|---|---|---|---|

| 核心功能 | 姿态控制驱动:依据提供的动作视频驱动图片人物运动 | 面部替换与表情操纵:专注于面部特征的替换和精细控制 | 文本生成视频 / 图片生成视频:更侧重于从文本或单图生成视频内容 |

| 控制精度 | 高:旨在精确复现提供的动作序列 | 中高(仅限于面部区域) | 可变:依赖文本描述或初始图片的精确度 |

| 生成内容长度 | 可达10秒 | 通常较短 | 可变,部分模型可生成较长片段 |

| 用户体验门槛 | 待公开 | 部分工具开源,但本地部署需技术能力;部分在线应用简化操作 | 逐步降低,更多云端服务提供图形界面 |

| 主要优势 | 动作迁移、多人支持、强泛化能力 | 面部控制精度高、技术相对成熟 | 创意发散性强、从无到有生成 |

| 主要局限/挑战 | 尚未开放体验 | 常与虚假信息关联、伦理风险高、全身动作生成非其重点 | 对复杂、精确的人物动作控制相对较弱 |

简要总结对比:

- 与深度伪造技术相比,Follow-Your-Pose-v2更专注于全身动作的迁移与控制,而非单纯的面部替换,应用场景有所不同。但深度伪造技术在面部精度上非常成熟。

- 与Runway Gen-3 等文本生成视频模型相比,Follow-Your-Pose-v2的核心优势在于提供了更精确、可控的姿态引导。文本生成视频自由度更高,但要生成特定精确动作则更难。

- 预计Follow-Your-Pose-v2在需要高度控制角色动作的场景(如广告模板、特定舞蹈动作生成)中会有优势,而在天马行空的创意生成方面,可能文本引导模型更灵活。

常见疑问解答

- Q:我的照片会被上传到服务器吗?隐私如何保障?

A:这取决于模型未来提供的服务模式。如果提供云端API,数据需上传处理;如果是本地部署版本,则数据留在本地。用户需关注官方发布的隐私政策。 - Q:生成的内容会涉及版权或伦理问题吗?

A:会。技术本身是中立的,但使用方式至关重要。未经他人同意将其肖像用于制作视频可能涉及法律风险。同时,AI生成内容的信息真实性也可能被滥用,需警惕“深度伪造”带来的虚假信息问题。