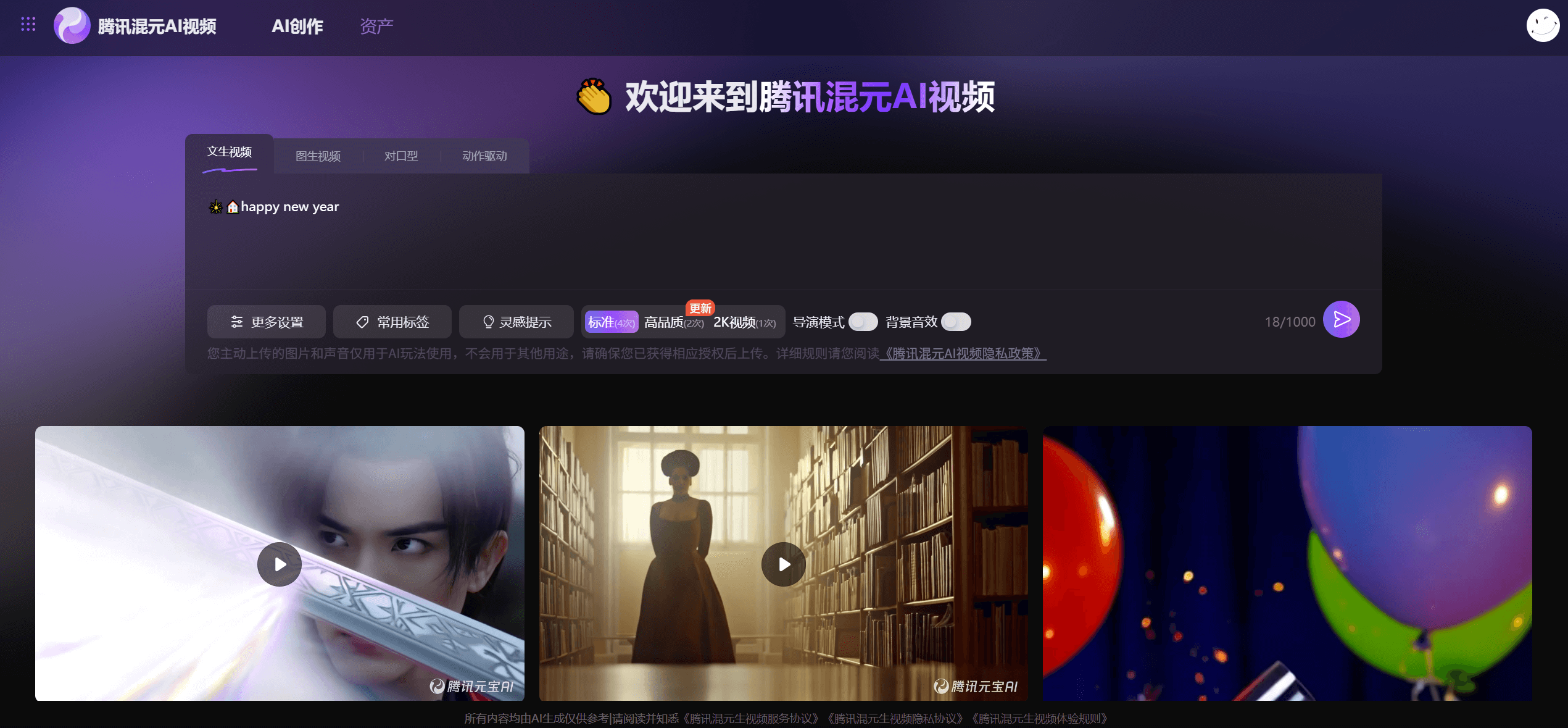

腾讯混元开源图生视频模型:输入静态图像生成5秒动态视频,支持多模态控制和主体一致性。适用于电商展示/数字人直播等场景,立即体验高效视频创作。

混元图生视频模型技术解析

腾讯开源的混元图生视频模型(HunyuanVideo-I2V)是基于130亿参数的多模态大模型,可将静态图像转化为5秒动态视频。其核心创新在于融合文本、图像、音频等多模态输入,通过“图像定义身份、文本控制动作”的机制,实现主体一致性视频生成。

- 在线体验: https://video.hunyuan.tencent.com/

- HuggingFace 模型地址: https://huggingface.co/tencent/HunyuanVideo-I2V

- Github 地址: https://github.com/Tencent/HunyuanVideo-I2V/

核心能力升级

1. 多模态精细控制

- 跨模态输入:支持图像+文本生成基础视频,扩展音频驱动对口型、姿态控制动作,实现音画同步表演。

- 多主体交互:可同时输入人物与物体图片(如“男子手持薯片”),生成自然互动场景。

2. 工业级一致性保障

- 采用身份增强机制,确保人物在换装、场景迁移中五官、服饰特征不变形,优于主流开源方案。

3. 局部编辑与植入

- 支持视频片段中替换/插入新元素(如将广告牌内容替换为品牌Logo),无需重新生成全片。

示例:

提示词如下:

纪录片风格,写实,中景,写字楼内,有很多工位,坐在工位上是一群猕猴,在电脑面前敲代码,镜头平移,特写猕猴们思考,疑惑,焦躁的表情

生成的视频如下:

六大应用场景

- 短视频创作:单张图片生成抖音/小红书动态内容,降低创作门槛

- 电商动态展示:商品360°旋转演示,替代传统拍摄成本

- 数字人直播:音频驱动生成虚拟客服7×24小时播报

- 影视预演:快速制作分镜脚本与特效镜头预览

- 游戏开发:批量生成角色动作素材,缩短美术周期

- 教育演示:历史场景动态重现,提升知识传递效率

使用指南

1. 在线体验

- 官网入口(需登录):https://hunyuan.tencent.com/modelSquare/home/play?modelId=192

- 功能:单主体图生视频(多主体/音频功能逐步开放)

2. 本地部署

- 代码仓库:GitHub项目

- 模型下载:Hugging Face|ModelScope

- 硬件要求:推荐24G显存(如NVIDIA A6000),单次生成耗时约8分钟

产品评测分析

核心优势

- 跨模态控制领先:融合文本/图像/音频输入,实现动作、口型、场景三重精准控制,超越同类开源模型。

- 主体一致性突破:人物换装、位移时身份特征零偏差,满足商业级视频制作需求。

- 工业场景适配强:提供API接口,可直接接入电商、游戏生产线。

显著短板

- 硬件门槛高:需专业级显卡(如A6000),消费级设备难部署。

- 生成效率受限:单卡生成4秒视频需8分钟,难以满足实时需求。

- 动态复杂度不足:多主体交互时肢体协调性偶现失真,复杂物理模拟需人工优化。

总结:混元图生视频是专业创作者的高效工具,尤其适合数字人、电商等需主体一致的场景。开源策略加速生态发展,但个人用户需权衡硬件成本,高频使用建议搭配腾讯云API服务。