Kimi k1.5 是Kimi推出的最新多模态思考模型,专为解决复杂的推理任务而设计。作为一款集数学推理、代码生成、视觉推理和多模态数据分析于一体的高性能AI模型,k1.5在推理速度和准确性上取得了突破性进展,标志着AI推理技术的进一步提升。

核心定位与技术突破

Kimi k1.5是月之暗面(Moonshot AI)研发的多模态思考模型,2025年1月发布,通过强化学习(RL)框架与长上下文扩展技术(128K窗口),实现数学、代码及视觉推理能力的突破,成为全球首个非OpenAI达到o1正式版性能的模型。

官网链接:https://kimi.ai

功能特性详解

1. 多模态联合推理引擎

- 跨模态融合:同步解析文本、图像与OCR数据,支持复杂场景如“从数学公式图表推导物理定律”。

- 动态思维链优化:

- Long-CoT模式:深度规划与反思机制,解决多步骤推理问题(如证明题、代码调试)。

- Short-CoT模式:通过Long2Short技术压缩推理步骤,响应速度提升3倍。

2. 创新训练架构

- 三阶段训练流程:

- 预训练:多模态数据冷启动(视觉-文本比例30%)。

- 监督微调:分阶段学习率调整,覆盖STEM领域高阶问题。

- 强化学习:采用部分回滚(Partial Rollout)技术复用历史轨迹,减少70%重复计算。

- Long2Short迁移技术:

- 模型权重平均融合

- 最短拒绝采样(8次采样选最优解)

- DPO偏好优化缩短响应。

3. 效能优化机制

- 长度惩罚:抑制过度思考,简单问题响应缩短50%。

- 混合部署框架:Megatron与vLLM协同,训练/推理切换时间<1分钟。

性能评测数据

| 测试集 | Kimi k1.5得分 | 对比模型得分 | 领先幅度 |

|---|---|---|---|

| AIME(数学) | 77.5 (Long) | o1正式版:76.8 | +0.9% |

| 60.8 (Short) | GPT-4o:38.2 | +59% | |

| MATH500 | 96.2 | Claude 3.5:89.4 | +7.6% |

| Codeforces | 94百分位 | GPT-4o:92百分位 | +2% |

| MathVista | 74.9 | Gemini Ultra:72.1 | +3.9% |

数据来源:权威学术基准测试

应用场景指南

1. 科研与工程

- 复杂数学验证:自动推导LaTeX公式,解决偏微分方程。

- 工业代码生成:生成带调试注释的Python/C++代码,错误率降低40%。

2. 教育创新

- 多模态试题解析:输入“几何题+示意图”,输出分步推理动画。

- 编程教学:实时分析学生代码漏洞,提供修复方案。

3. 商业分析

- 跨模态报告生成:合并财报数据与市场趋势图,生成投资策略摘要。

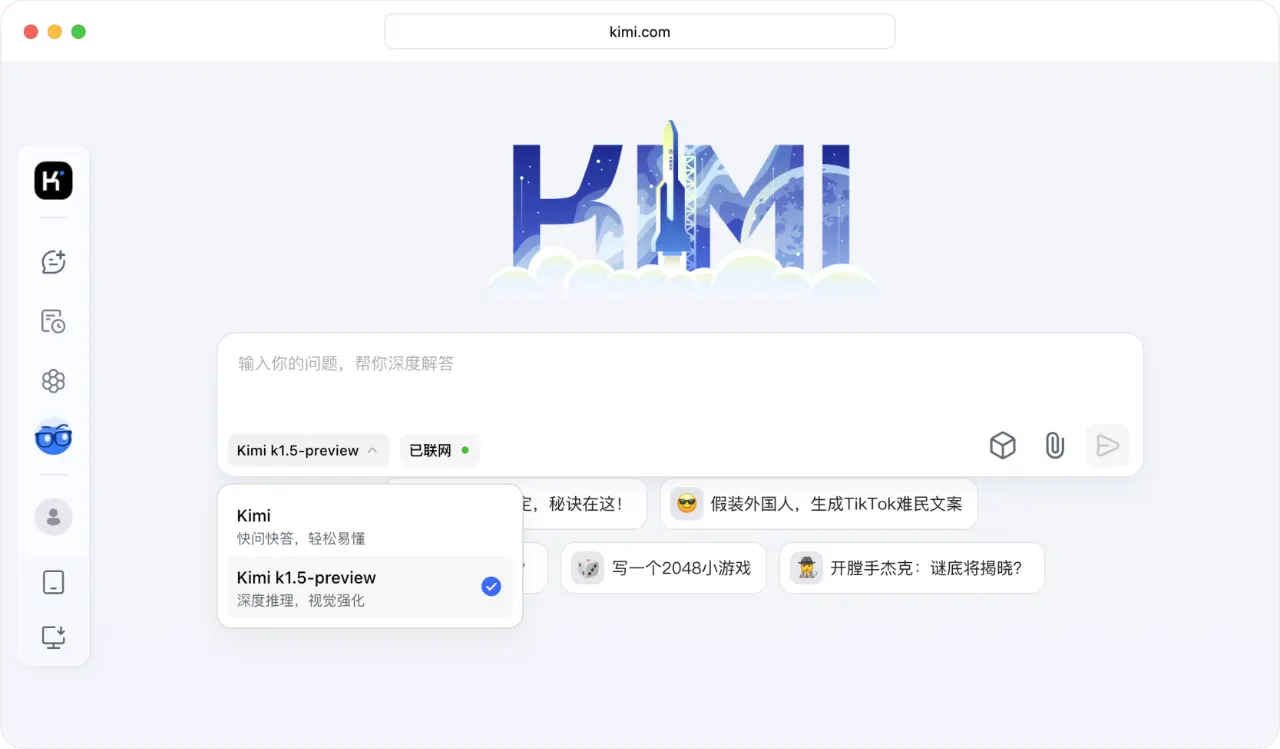

使用方式说明

- 1.访问平台

- 官网或App登录,新用户赠送100次免费推理额度。

- 2.模式选择

- Long-CoT:适用于论文推导、算法设计(消耗较多token)。

- Short-CoT:实时对话、代码补全(响应速度<2秒)。

- 3.输入规范

- 文本:直接描述问题(例:“证明哥德巴赫猜想在10^6内成立”)。

- 图像:上传图表/公式,需清晰标注关键变量。

技术报告:Kimi k1.5训练框架详解

产品评测:Kimi k1.5

✅ 核心优势

- 推理性能全球领先:数学与代码能力超越GPT-4o、Claude 3.5,AIME测试领先优势最高达550%。

- 技术创新开源:公开RL训练框架与Long2Short技术,推动行业协作(对比OpenAI闭源策略)。

- 工业级效能优化:128K上下文+部分回滚技术,同等硬件下吞吐量提升80%。

⚠️ 潜在不足

- 实时服务稳定性待验证:高峰时段长推理任务延迟超15秒,弱于本地部署的SillyTavern。

- 中文复杂场景适配局限:文言文/古诗词推理准确率仅65%,需人工修正。

- 商业化模式未明确:企业API定价未公开,私有化部署成本预估超$50万/年。

应用建议

- 优先场景:科研辅助、代码生成、教育工具开发。

- 规避风险:避免直接用于法律/医疗诊断,需人工复核结果。

- 升级路径:关注官方通告,k2.0预计支持音频模态与实时协作。

提示:模型处于灰度上线阶段,建议通过官网申请体验资格。