美团不再只送外卖,开始送“AI大餐”!LongCat重磅开源,推理速度碾压全场!

还记得那些需要昂贵硬件才能运行的大模型吗?或者为了等AI生成一段代码而焦躁不安的时刻?美团在2025年9月1日扔出了一颗“技术核弹”——正式发布并开源了其自研大模型LongCat-Flash-Chat。这不仅是美团首次曝光其“Building LLM”战略成果,更以5600亿总参数的庞大架构和每百万token低至5元的输出成本,彻底颠覆了高效AI的性价比认知。

什么是LongCat?外卖巨头的美味“AI套餐”

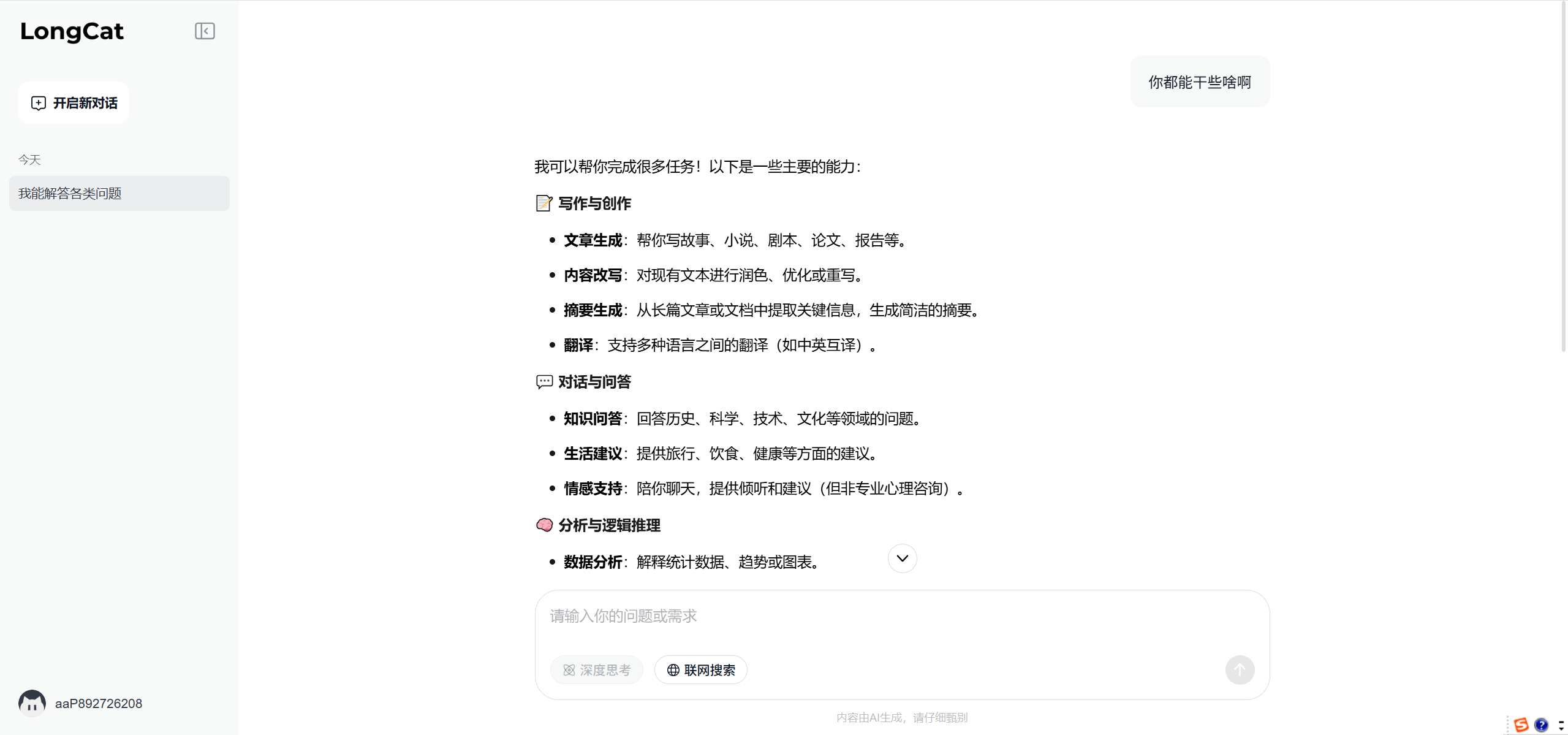

LongCat是美团基于自研大模型LongCat-Flash-Chat打造的在线智能对话平台。但它远不止是一个聊天机器人——而是一个支持知识问答、文本生成、数据分析、编程支持甚至情感陪伴的全能型AI助手。最让人惊喜的是,它采用创新的混合专家模型(MoE)架构,总参数量高达5600亿,但每个token仅激活186亿至313亿参数(平均约270亿),实现了计算效率与性能的双重优化。

💡 简单理解:就像一家拥有5600位专家的咨询公司,但每次只邀请最相关的200多位专家为你服务,既专业又高效。

核心功能:你的全能型AI伙伴

LongCat-Flash-Chat的能力全面得令人惊讶,几乎覆盖了工作、学习和娱乐的所有需求:

- 自然语言对话:能进行流畅自然的对话交流,准确理解用户意图。

- 联网搜索与实时信息整合:支持联网搜索功能,能实时获取互联网上的最新信息。

- 多领域知识应用:具备科学、技术、文化、历史、艺术等多领域的知识。

- 文本生成与创作:支持文章写作、故事创作、文案撰写等多种文本类型的生成任务。

- 代码生成与解析:可以生成多种编程语言的代码片段,对代码进行解析。

- 智能体任务优化:在智能体任务中表现出色,具备强大的工具使用和复杂场景处理能力。

技术突破:MoE架构与“零计算专家”机制

LongCat-Flash-Chat的技术创新令人印象深刻。它采用混合专家模型(MoE)架构,总参数量达5600亿,但每个token仅激活平均约270亿参数,实现了算力的高效利用。

更引人注目的是其“零计算专家”机制,通过PID控制器实时微调专家偏置,将单token平均激活量稳定在约270亿。加上层间铺设的跨层通道,使MoE的通信和计算能很大程度上并行,极大提高了训练和推理效率。

这些技术创新带来了实实在在的性能提升:在H800上实现单用户100+ tokens/s的推理速度,输出成本低至5元/百万token,让高性能AI变得真正实惠。

实测性能:基准测试表现惊艳

根据多项基准测试结果,LongCat-Flash-Chat的表现相当亮眼:

- 通用领域知识:在ArenaHard-V2基准测试中取得86.50的优异成绩,位列第二;MMLU得分为89.71,CEval得分为90.44

- 智能体工具使用:在τ²-Bench中表现超越其他模型;在VitaBench中以24.30的得分位列第一

- 编程能力:在TerminalBench中以39.51的得分位列第二;在SWE-Bench-Verified中得分为60.4

- 指令遵循:在IFEval中以89.65的得分位列第一;在COLLIE和Meeseeks-zh中也获得最佳成绩,分别为57.10和43.03

LongCat-Flash-Chat深度评测与竞品对比

LongCat-Flash-Chat的横空出世,让2025年的大模型市场竞争更加激烈。作为美团的首款开源大模型,它展现出了令人印象深刻的实力,但也面临一些挑战。

✅ 核心优势:

- 高效架构设计:采用混合专家模型(MoE)架构,总参数5600亿但平均仅激活270亿参数,实现了高性能与低消耗的完美平衡。

- 智能体能力突出:在VitaBench中以24.30的得分位列第一,在复杂场景处理中展现出明显优势。

- 推理速度极快:在H800上实现单用户100+ tokens/s的推理速度,响应速度远超许多同类产品。

- 使用成本低廉:输出成本低至5元/百万token,大大降低了使用门槛。

- 综合能力全面:在编程、指令遵循、多领域知识等方面表现均衡,没有明显短板。

❌ 主要不足:

- 生态系统初建:作为新发布的模型,开发者社区和工具链生态还在建设中。

- 实际应用案例有限:虽然基准测试成绩优秀,但大规模实际应用案例还有待验证。

- 多模态支持有限:目前主要专注于文本处理,在多模态能力方面相较于一些竞争对手略显不足。

🔍 与主要竞品对比:

| 特性维度 | 美团 LongCat-Flash-Chat | DeepSeek-V3.1 | Kimi-K2 | 豆包 |

|---|---|---|---|---|

| 核心架构 | MoE(5600亿总参数) | 未公开 | 未公开 | 未公开 |

| 智能体能力 | 领先 (VitaBench第一) | 中等 | 中等 | 一般 |

| 推理速度 | 极快 (100+ tokens/s) | 较快 | 中等 | 较快 |

| 使用成本 | 很低 (5元/百万token) | 中等 | 中等 | 免费 |

| 综合能力 | 均衡优秀 | 优秀 | 良好 | 日常使用足够 |

| 最佳适用场景 | 企业级复杂应用 | 通用场景 | 长文本处理 | 日常简单应用 |

竞品分析概要:

- DeepSeek-V3.1:在通用场景表现优异,综合能力强劲,但在智能体任务和成本控制方面不如LongCat。

- Kimi-K2:擅长长文本处理,在文档分析和总结方面有优势,但整体性能均衡性稍逊。

- 豆包:最大优势是免费使用,适合日常简单应用,但在处理复杂任务和企业级应用方面能力有限。

适用场景:谁最适合使用LongCat?

LongCat-Flash-Chat的能力特点使其在一些特定场景中尤为出色:

- 学生与学习者:可用于课程辅导、知识查询、数学解题和语言学习。

- 内容创作者/写作者:支持文章撰写、文本润色和创意生成,提升写作质量与效率。

- 开发者/技术人员:提供代码生成、调试与技术文档支持,助力编程与技术研发。

- 企业用户/决策者:通过数据分析和合理建议,辅助商业分析与决策制定。

- 普通用户/AI爱好者:用于日常信息查询、实用技巧获取、娱乐互动与情感交流。

总结

LongCat-Flash-Chat的发布,不仅是美团技术实力的一次亮相,更为大模型发展提供了新思路:通过精巧的架构设计,完全可以在保持高性能的同时大幅降低计算成本。虽然作为新玩家,其生态建设和实际应用验证还需要时间,但其出色的基准测试表现、惊人的推理速度和极低的使用成本,已经让它成为2025年最值得关注的开源大模型之一。

技术的意义不在于参数的庞大,而在于效率的提升和普及的可能。LongCat-Flash-Chat正是朝着这个方向迈出的坚实一步——让AI从科技巨头的实验室,走向寻常百姓的日常生活。