美团放出AI大招!LongCat大模型开源,5600亿参数碾压同级选手

送外卖的美团开始送”AI大餐”了!最近美团正式开源了其大模型LongCat-Flash-Chat,这个拥有5600亿参数的大家伙,不仅在性能上媲美顶级闭源模型,还完全免费开放。这意味着无论是个人开发者还是企业团队,都能用上堪比Claude4 Sonnet级别的AI能力。

- 基于LongCat-Flash-Chat的AI助手:longcat.ai

- Hugging Face 提供模型权重与调用接口:huggingface.co/meituan-longcat

- GitHub地址:github.com/meituan-longcat/LongCat-Flash-Chat

- 技术报告:tech_report.pdf

什么是LongCat?外卖巨头的技术逆袭

LongCat-Flash-Chat是美团基于自研大模型打造的对话增强模型,采用创新的混合专家架构(MoE),总参数量达到5600亿,但每次只激活约270亿参数,既保证了强悍的性能,又大幅降低了计算成本。

这个模型最厉害的地方在于它通过了大量对话训练和人类反馈优化,在多轮对话、工具调用和智能体任务方面表现突出,还支持长达128K的上下文输入,相当于能一次性处理一本300页的书籍。

核心功能:你的全能AI助手

- 智能专家架构:5600亿参数MoE设计,平均仅激活270亿参数,实现高效推理

- 动态激活机制:按需调用不同专家,推理速度超过100 tokens/秒

- 超长记忆力:支持128K上下文,处理长文档和多轮对话毫无压力

- 对话优化:经过指令调优和人类反馈对齐,对话能力自然流畅

- 智能体支持:支持函数调用、多步骤任务执行和工具协作

- 完全开源:MIT协议开源,可免费商用和研究

性能表现:碾压同级选手

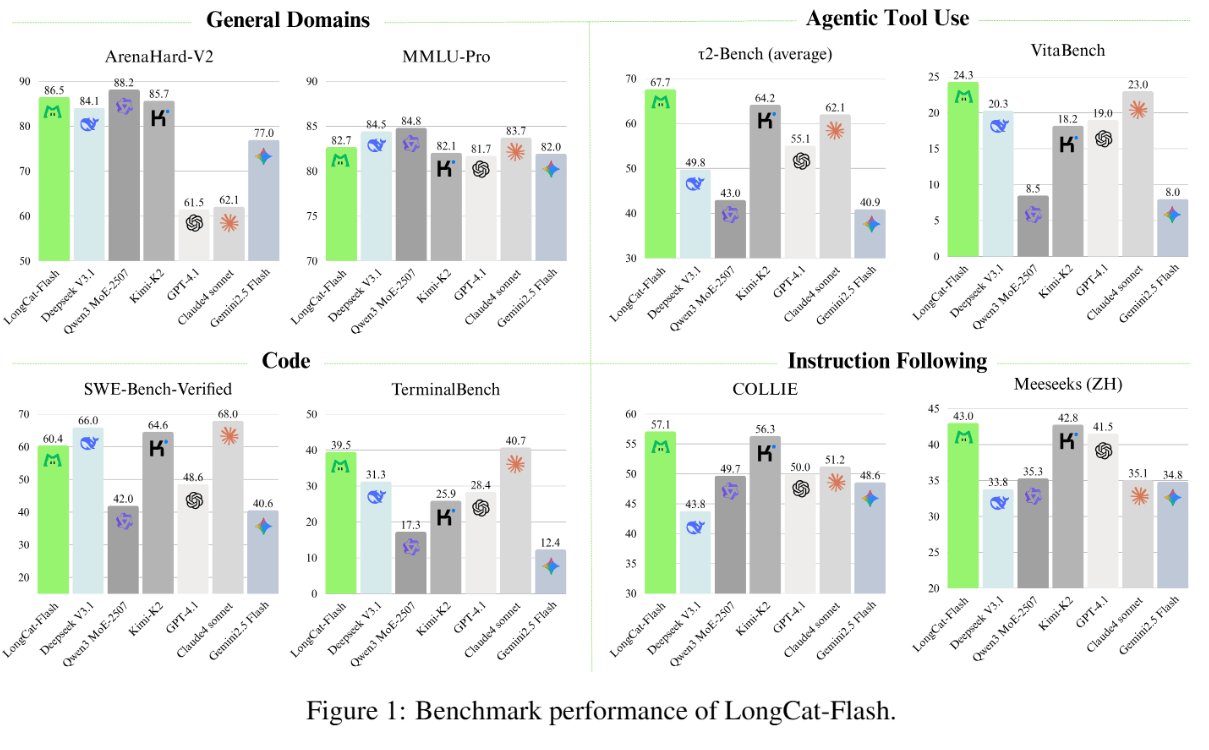

LongCat在多项测试中表现惊艳,特别是在智能体工具调用和指令遵循方面,甚至超越了DeepSeek-V3.1、Qwen3 MoE-2507等知名模型,与闭源的Claude4 Sonnet打得有来有回。

在TerminalBench编程测试中,LongCat与公认的”编程之王”Claude4 Sonnet不相上下,展现出强大的代码理解和生成能力。

适用场景:谁最适合使用?

- 智能体开发:利用其工具调用和多步骤推理能力,构建自动化智能体系统

- 企业应用:作为智能客服、知识问答、数据分析助手的后端核心

- 软件开发:帮助开发者进行代码生成、调试和优化

- 长文本处理:处理法律文档、科研论文、咨询报告等长内容

- 个人使用:日常问答、学习辅助和逻辑推理训练

LongCat-Flash-Chat深度评测与竞品对比

✅ 核心优势

- 性能强劲:在工具调用和指令遵循方面超越多个知名开源模型

- 成本效益高:MoE架构大幅降低计算成本,推理效率提升明显

- 长文本优势:128K上下文长度处于行业领先水平

- 开源免费:MIT协议完全开源,可自由商用和修改

- 专项能力突出:在编程和智能体任务方面表现尤其亮眼

❌ 主要不足

- 生态建设初期:相比成熟模型,周边工具和社区生态还在建设中

- 多模态支持有限:目前主要专注于文本处理,缺乏图像和语音能力

- 实际应用案例少:作为新发布模型,大规模商业应用案例有待验证

🔍 竞品对比

| 特性维度 | LongCat-Flash-Chat | DeepSeek-V3.1 | Qwen3 MoE-2507 | Claude4 Sonnet |

|---|---|---|---|---|

| 参数规模 | 5600亿 (MoE) | 6850亿 | 2507亿 (MoE) | 未公开 |

| 上下文长度 | 128K | 128K | 128K | 200K |

| 开源情况 | 完全开源 (MIT) | 部分开源 | 开源 | 闭源 |

| 推理速度 | 优秀 (100+ tokens/秒) | 良好 | 良好 | 优秀 |

| 工具调用 | 优秀 | 良好 | 良好 | 优秀 |

| 编程能力 | 优秀 (媲美Claude4) | 优秀 | 良好 | 优秀 |

| 商用成本 | 免费 | 付费API | 免费 | 付费 |

选择建议:

- 要完全开源免费:选LongCat或Qwen3,均可商用

- 要最强编程能力:LongCat或Claude4,但Claude4需付费

- 要最长上下文:Claude4支持200K,但为闭源付费

- 要生态成熟度:DeepSeek-V3.1有更丰富的周边工具

如何快速上手体验

LongCat-Flash-Chat已经在多个平台开放,提供多种使用方式:

🌐 在线体验

- 直接访问 longcat.ai 官网,无需注册即可在线体验模型对话能力

🛠 开发接入

- Hugging Face 提供模型权重与调用接口:huggingface.co/meituan-longcat

- GitHub地址:github.com/meituan-longcat/LongCat-Flash-Chat

- 技术报告:tech_report.pdf

💻 本地部署

- 支持docker部署和本地推理,提供完整的API接口和文档说明

总结

美团的LongCat-Flash-Chat无疑为开源大模型领域投下了一枚重磅炸弹。5600亿参数的规模、专业级的性能表现、完全开源的诚意,让它在众多模型中脱颖而出。虽然作为新秀还需要经过更多实际应用的检验,但其出色的基准测试表现和开放的生态策略,已经让它成为2025年最值得关注的开源模型之一。

从送外卖到搞AI,美团的这次技术突围让人眼前一亮。LongCat的开源不仅降低了AI技术的使用门槛,更为整个行业的发展注入了新的活力。未来,或许会有更多企业像美团一样,用开源技术推动AI普及,让智能计算真正惠及每一个人。