国产AI黑马Moonlight实测:160亿参数只激活30亿,训练成本直降50%!

还在为大模型训练烧显卡而肉疼吗?一家名为月之暗面(Moonshot AI)的中国公司,2025年放出了一个大招——Moonlight模型!这可不是普通的AI模型,它能用一半的成本达到同类模型两倍的效率,像极了精锐特种部队,平时各司其职,需要时精准出击。

这款模型采用了创新的混合专家(MoE)架构,理解起来很简单:就像一家大医院有各个科室,看病时不需要所有医生都来会诊,而是根据病情选择对应的专家。Moonlight就是这样,总共拥有160亿参数,但每次只激活30亿参数,大大节省了计算资源。

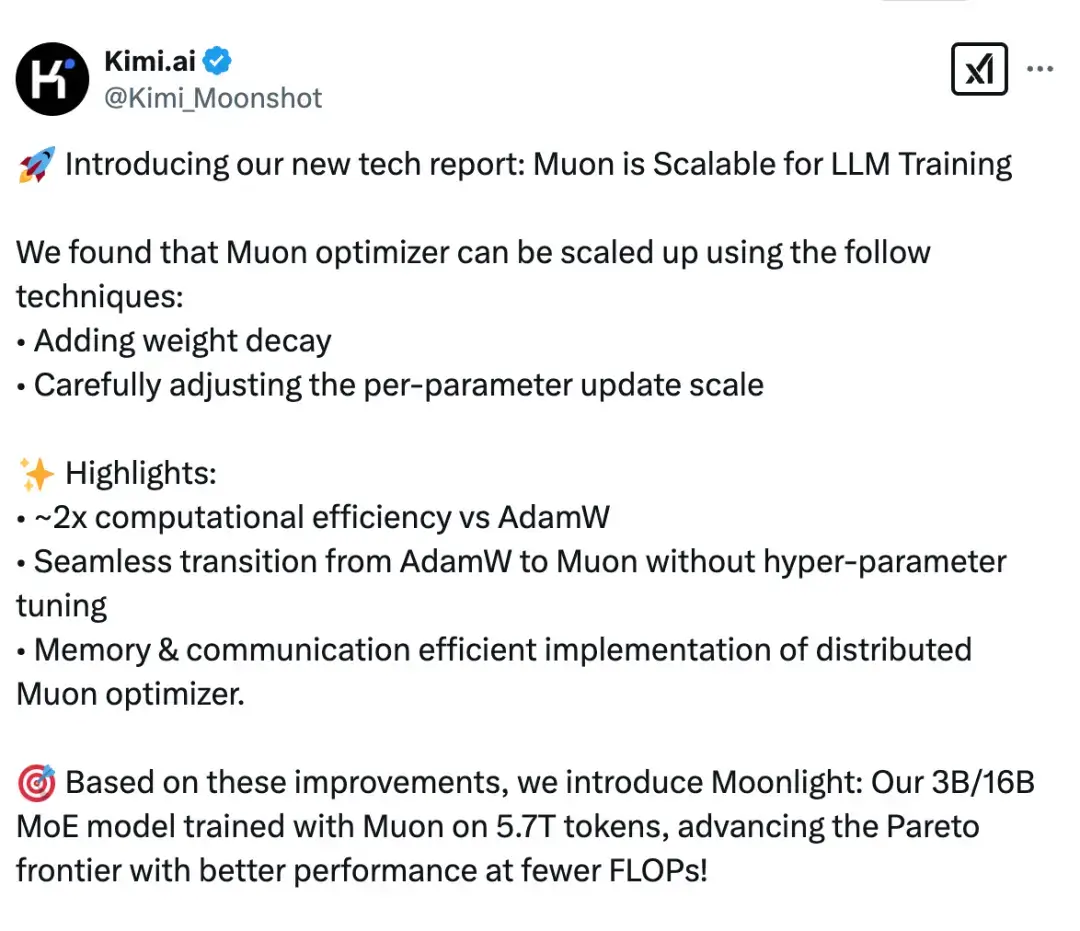

更厉害的是,它搭载了自研的Muon优化器,训练效率直接翻倍,让中小企业和研究机构也能玩转大模型。实际表现到底如何?一起来看看2025年的最新实测结果!

- 官网:https://www.moonshot.ai/

- 代码:https://github.com/MoonshotAI/Moonlight

- 模型:https://huggingface.co/moonshotai

- 论文:https://github.com/MoonshotAI/Moonlight/blob/master/Moonlight.pdf

核心特性:小而精的智能专家

🚀 高效计算,省钱省力

- Moonlight最大的亮点就是智能路由机制。它不会每次计算都动用全部参数,而是像智能调度系统一样,根据任务类型选择最合适的“专家”来处理。

- 这种设计让它的推理效率大幅提升,内存占用显著减少。对于需要实时响应的应用场景(如在线客服、即时编程助手)特别友好,响应更快,成本更低。

🧠 训练优化黑科技

Moonlight采用的Muon优化器是其核心技术,它解决了传统训练中的两个老大难问题:

- 通过矩阵正交化技术,确保参数更新更加准确

- 根据不同参数矩阵的形状动态调整学习率,让训练更加稳定

效果如何?达到相同性能所需的计算量只有传统方法的52%,云训练成本直接砍半,这让更多中小机构也能负担得起大模型训练。

🏆 性能表现不俗

在多类基准测试中,Moonlight的表现可圈可点:

| 测试任务 | Moonlight-16B | 同规模模型 |

|---|---|---|

| 综合知识 | 70.0 | 65.6 |

| 代码生成 | 48.1 | 42.1 |

| 数学推理 | 77.4 | 79.1 |

| 中文理解 | 77.2 | 75.0 |

特别值得一提的是,Moonlight仅用了5.7万亿token的训练数据,就在多项任务上超越了用更多数据训练的同类模型,真正做到事半功倍。

适用场景:

🧑💻 中小型企业

- 想要尝试大模型能力但预算有限,Moonlight是性价比极高的入门选择。

🏥 专业领域应用

- 在医疗、金融等垂直领域,Moonlight可以快速微调适配,处理专业文档和数据分析。

👨🔧 开发者社区

- 开源特性让开发者可以自由修改和优化,构建自己的专属AI助手。

🌐 多语言场景

- 虽然主打中文市场,但Moonlight在处理英语、代码等多语言任务上同样表现优异。

使用指南:如何快速上手

基础使用(适合初学者)

- 通过Hugging Face直接调用模型API

- 使用提供的示例代码快速验证想法

- 在线体验平台测试模型效果

高级部署(适合企业用户)

- 使用vLLM或SGLang等推理引擎部署

- 配置GPU集群(建议24GB显存以上)

- 根据业务需求定制MoE路由策略

Moonlight深度评测与竞品对比

✅ 核心优势

- 训练成本大幅降低:Muon优化器让训练效率提升至AdamW的2倍,训练计算量节省约48%,让更多机构能够参与大模型研发。

- 推理效率优异:MoE架构实现更高的推理效率和内存节省,在相同硬件条件下支持更高并发。

- 性能表现突出:仅用5.7T训练token就在多项基准测试中超越使用更多token的竞品,显示出色的数据利用效率。

- 开源生态完善:完整开放模型权重、训练中间检查和Muon优化器实现,推动社区协作和创新发展。

⚠️ 使用局限

- 上下文长度限制:标准版支持8K tokens的上下文长度,在处理长文档时可能不如一些支持更长上下文的竞品。

- 硬件要求较高:16B模型推理需要足够的GPU资源,对资源有限用户不友好。

- 调试复杂度高:MoE动态路由机制增加了故障定位难度,需要专业团队进行维护和优化。

🆚 2025年主流开源大模型对比

| 特性维度 | Moonlight | DeepSeek-V3 | 百川3-MoE |

|---|---|---|---|

| 核心优势 | 训练效率极高,计算成本低 | 上下文长度可能具有优势 | 中文优化可能较好 |

| 开源程度 | 高(完整开源模型和优化器) | 中等 | 较高 |

| 推理效率 | 高(MoE架构,激活参数少) | 中等 | 较高 |

| 中文理解 | 强(C-Eval:77.2, CMMLU:78.2) | 可能强劲 | 可能强劲 |

| 部署难度 | 中等(需要一定技术基础) | 中等 | 中等 |

对比分析:

- DeepSeek-V3:可能在长上下文处理上具有优势,适合需要处理长文档的场景。

- 百川3-MoE:在中文理解和生成方面可能表现优异,特别适合中文场景的应用开发。

选型建议:

- 如果追求极致的训练和推理效率,且需要完全开源透明,Moonlight是很好的选择。

- 如果需要处理超长文档,可以关注在上下文长度方面可能有优势的模型。

- 如果主要面向中文市场,可以对比各模型在中文任务上的最新表现。

成本分析:真的那么省钱吗?

Moonlight最大的优势之一就是成本控制。相比传统密集模型,它能够在多个环节节省开支:

- 训练成本:Muon优化器减少训练成本,让更多机构也能参与大模型研发。

- 推理成本:稀疏激活特性使推理阶段的计算量减少,直接降低API调用成本。

- 部署成本:更高的计算效率意味着可以用更少的硬件资源处理更多请求。

Moonlight值得尝试吗?

总的来说,Moonlight在效率与性能的平衡上表现不错。它不是参数最多的模型,但它在自己擅长的领域做出了特色——用更少的资源做更多的事。

对于中小型企业、研究机构和开发者社区来说,Moonlight提供了一个机会:以可承受的成本获得大模型能力。虽然它在长上下文处理等方面还有局限,但开源特性和效率优势使其成为2025年值得关注的国产模型之一。

在AI技术快速发展的今天,像Moonlight这样注重效率的模型也代表了一个发展方向——通过架构创新和优化实现更高效的智能计算。

温馨提示:Moonlight完全开源,感兴趣的用户可以直接访问Hugging Face仓库下载模型和代码。建议先从小规模实验开始,逐步评估其在实际业务中的效果。