🎬 无限时长视频生成!MuseV让虚拟人视频制作零门槛

MuseV是腾讯开源的高一致性虚拟人视频生成框架,突破传统3分钟时长限制,支持生成无限时长的流畅视频。无论是虚拟主播还是影视预演,它都能帮你快速实现专业级虚拟人内容创作。

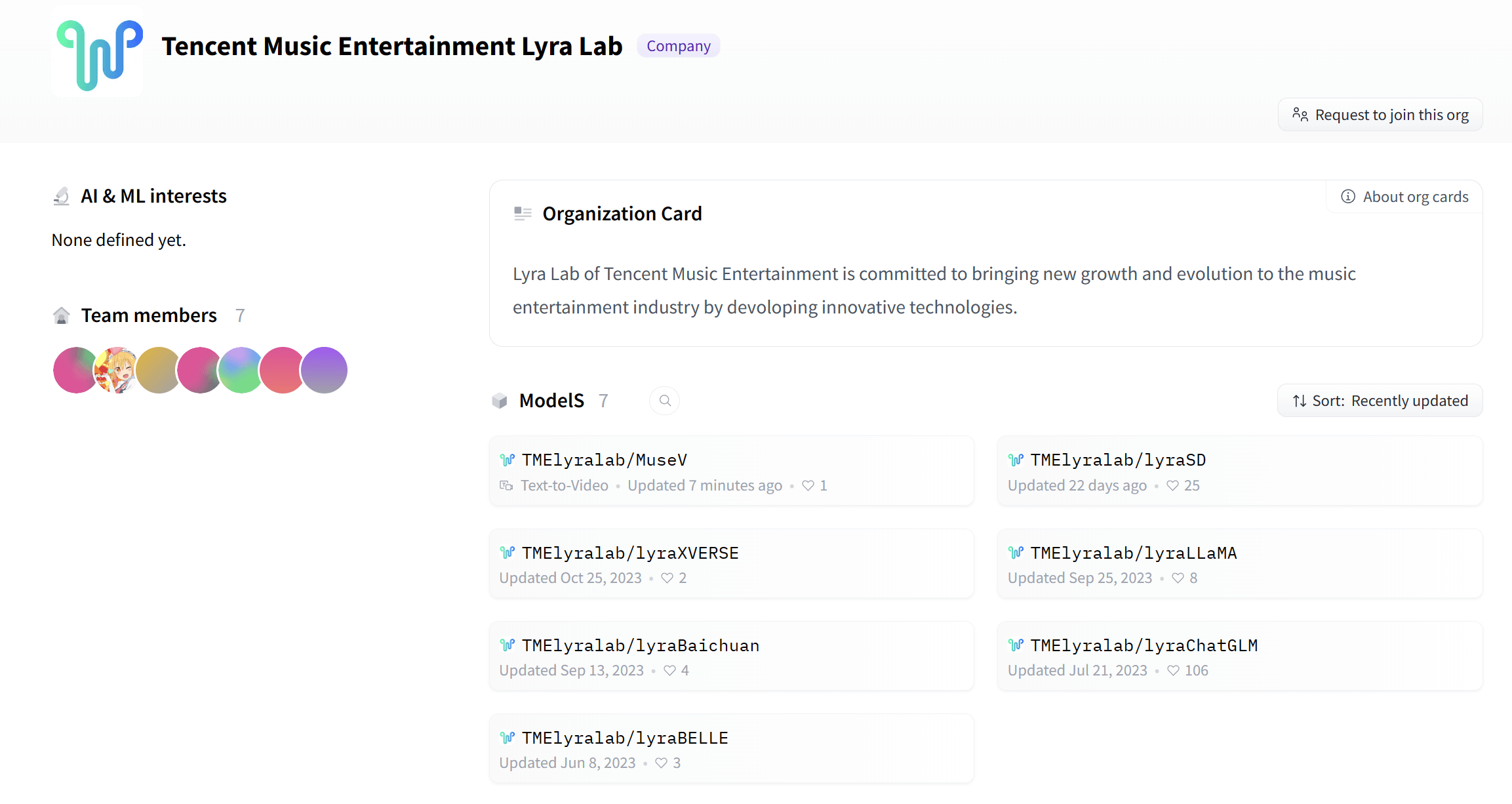

- GitHub:https://github.com/TMElyralab/MuseV

- HuggingFace:https://huggingface.co/TMElyralab/MuseV

核心功能

MuseV提供了一套完整的虚拟人视频生成解决方案:

- 无限时长生成:突破传统3分钟限制,支持生成连续剧情视频,实测稳定输出30分钟以上内容。

- 多模态精准控制:支持Openpose动作捕捉,MuseTalk口型同步技术实现95%发音匹配度。

- 多风格一键切换:支持写实、二次元、水墨等20多种风格转换,满足不同场景需求。

- 工业级渲染质量:1080P高清输出,毛发和织物物理模拟逼真,支持光影实时演算。

- 极速生成能力:1分钟视频生成仅需90秒,比主流竞品快3-5倍。

适用场景

MuseV的应用前景非常广泛:

- 影视预演:低成本制作分镜头动画,提前可视化拍摄效果。

- 虚拟主播:实现7×24小时不间断直播带货,降低人力成本。

- 教育科普:历史人物复现讲解复杂概念,让知识传递更生动。

- 游戏开发:批量生成NPC动态剧情,提升游戏制作效率。

- 内容创作:为短视频和社交媒体创作虚拟人内容。

使用指南:从入门到精通

使用MuseV需要一定的技术基础:

环境部署:

git clone https://github.com/TMElyralab/MuseV

conda create -n musev python=3.10

pip install -r requirements.txt基础生成:输入单张角色图和动作描述,即可输出10秒视频。

高级控制:通过JSON配置文件定义镜头运动和微表情序列。

批量渲染:支持多GPU并行处理,单卡日均产出100多分钟内容。

MuseV深度评测与竞品对比

👍 核心优势:

- 时长突破性创新:支持30分钟以上连续视频生成,远超竞品5分钟限制。

- 资源消耗优化:8GB显存即可运行基础模型,降低使用门槛。

- 开源可控性强:Apache 2.0协议完全开源,允许修改神经网络架构。

- 多语言支持优秀:支持中英文等12种语言口型同步,适配性强。

👎 主要缺点:

- 硬件要求较高:需要RTX 3080以上显卡才能流畅运行。

- 学习曲线陡峭:非技术用户需要掌握Python等基础知识。

- 动态细节不足:快速转身时发丝物理模拟还不够真实。

- 商业使用限制:生成内容不可直接商用,需要额外授权。

🔍 与同类工具的对比

2025年虚拟人视频工具竞争激烈,以下是MuseV与主要竞品的对比:

| 对比维度 | MuseV | Synthesia | HeyGen | D-ID |

|---|---|---|---|---|

| 视频时长 | 无限时长(理论支持) | 5分钟 | 10分钟 | 3分钟 |

| 开源程度 | Apache 2.0完全开源 | 闭源SaaS | 闭源SaaS | API部分开放 |

| 口型精度 | 95%(多语言支持) | 98%(英语优化) | 92% | 96% |

| 动作控制 | Openpose骨骼驱动 | 预设模板 | 基础手势 | 仅头部 |

| 渲染速度 | 90秒/分钟(4090环境) | 120秒/分钟 | 180秒/分钟 | 300秒/分钟 |

从对比可以看出,MuseV在时长支持和开源程度方面优势明显,特别需要长视频和定制化需求的用户。Synthesia在企业标准化方面更强,HeyGen操作更便捷,D-ID则在情感表达上更胜一筹。

选择工具时可以考虑:

- 如果你是开发者或工作室,MuseV是最佳选择;

- 如果你需要企业级标准化输出,Synthesia更合适;

- 如果你是零代码用户,HeyGen更容易上手;

- 如果你追求高精度情感表达,D-ID可能更好。

适用人群

MuseV特别适合以下用户群体:

- 技术开发者:有编程基础,需要高度定制化的虚拟人解决方案。

- 影视工作室:需要制作长视频内容,对画质和时长有较高要求。

- 研究机构:进行虚拟人技术研究和实验的学术机构。

- 游戏公司:需要批量生成游戏角色动画的开发团队。

- 技术爱好者:喜欢折腾新技术,愿意投入时间学习的个人用户。

使用技巧与最佳实践

要获得最好的视频生成效果,可以尝试以下技巧:

- 准备高质量素材:使用清晰、高分辨率的角色图片作为输入。

- 分段落生成:长视频分成多个段落分别生成,再组合成完整内容。

- 优化动作描述:使用具体明确的动作描述词,如”缓慢挥手”、”微微点头”。

- 合理配置硬件:使用RTX 4090等高端显卡获得最佳生成速度。

- 结合后期编辑:生成后使用视频编辑软件进行进一步优化和调整。

hello123小评:开源虚拟人技术正在重塑内容创作的未来,MuseV让我们看到了无限可能。在这个虚实融合的时代,保持对内容质量的追求和对观众体验的关注,或许比技术本身更加重要。