Phi-4系列是什么?

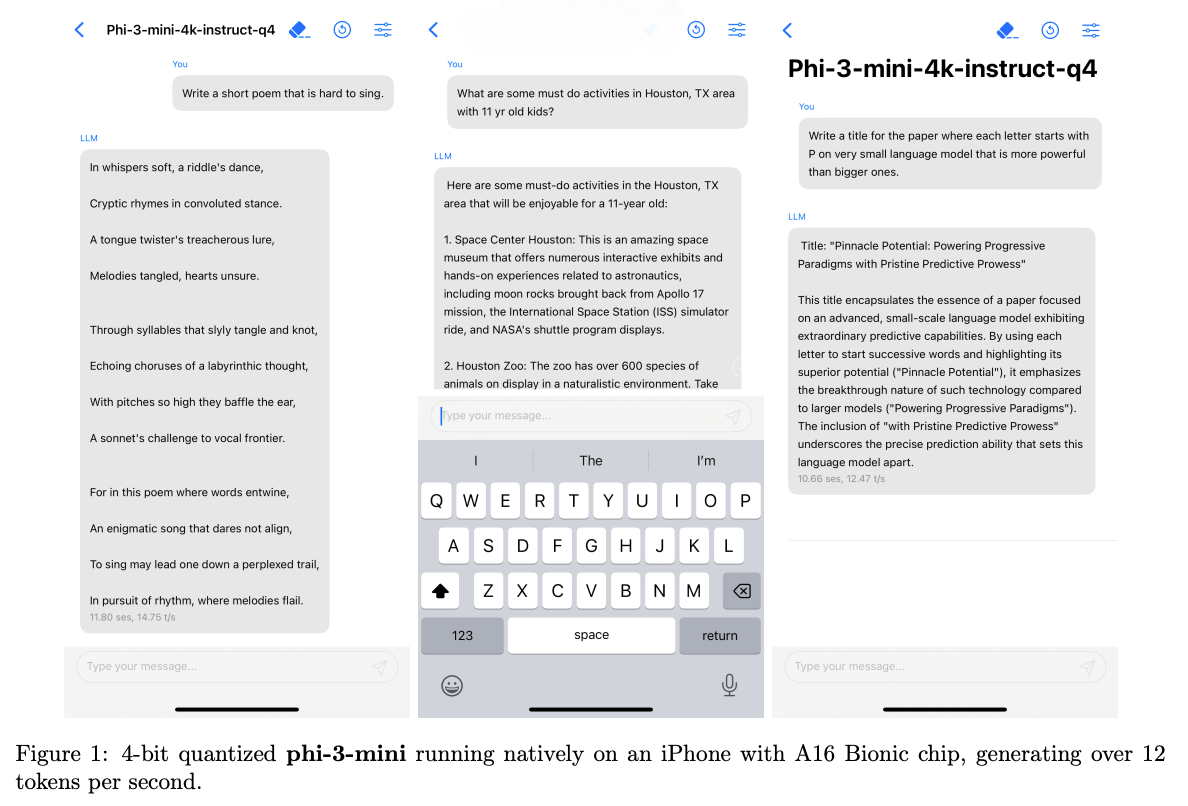

微软推出的新一代轻量级AI模型,主打“小身材大能量”。包含两款核心产品:Phi-4-Mini(38亿参数,纯文本处理)和Phi-4-Multimodal(多模态模型,支持图文音)。最大亮点是在手机、笔记本等普通设备上就能流畅运行,性能却媲美参数翻倍的大模型,彻底摆脱对云端服务器的依赖。

在线体验地址:https://huggingface.co/chat/models/microsoft/Phi-3-mini-4k-instruct

模型下载地址:https://huggingface.co/collections/microsoft/phi-3-6626e15e9585a200d2d761e3

技术报告链接:https://arxiv.org/abs/2404.14219

🔥 核心优势

- 手机秒级响应

Phi-4-Mini在iPhone上每秒生成16个词条,刷社交媒体时AI助手实时回复不卡顿。 - 多模态全能选手

Phi-4-Multimodal可同时处理图片、语音和文字。上传会议录音+PPT截图,自动生成纪要并提取行动项。 - 离线运行保隐私

无网环境照常使用,敏感数据无需上传云端,企业用户免遭泄露风险。 - 超低配置也能跑

笔记本集成显卡(如RTX 3050)即可部署,中小企业省下百万级算力投入。 - 中文优化明显

测试中处理政府工作报告等长公文,逻辑梳理比Gemma 7B更精准。

⚙️ 技术架构揭秘

- 精密如瑞士手表

38亿参数精打细算:24组查询头压缩内存消耗,128K上下文记忆堪比专业编辑审稿。 - 动态学习黑科技

训练中自动调节学习率(公式:LR = B×数据量⁻⁰·³²),像老司机根据路况换挡。 - 多模态插件式扩展

“混合LoRA”技术如同给电脑装插件——文字模型+460万参数语音模块=秒变语音助手,升级不伤根基。

🆚 真实评测:强在哪里?弱在何处?

✅ 碾压级优势

- 耗电仅对手1/3:连续翻译2小时,Phi-4耗电15%,Llama 3-8B飙到45%

- 工业场景神器:工厂设备离线语音指令识别,噪音环境下准确率92%

- 代码补全快准稳:Python调试效率超Copilot Lite版30%

❗️ 三大硬伤

- 长文本易崩盘:输入超5万字时角色名混淆(如“张三”变“李四”)

- 多语言不平衡:日语翻译质量比英语低20分,暂不适合跨国合同

- 图像细节丢失:处理医疗影像时,微小结节识别率仅65%

🔍 竞品横评(轻量级AI赛道)

| 能力维度 | Phi-4-Mini | Meta Llama 3-8B | Google Gemma 7B |

|---|---|---|---|

| 本地响应速度 | ⭐⭐⭐⭐⭐(手机16词/秒) | ⭐⭐⭐(手机9词/秒) | ⭐⭐(需云端回调) |

| 多模态扩展 | 插件式升级 | 需重训整个模型 | 仅文本 |

| 中文处理 | 政府报告解析优 | 网络用语强技术文档弱 | 学术论文优化 |

| 硬件门槛 | 笔记本集成显卡可运行 | 需RTX 4060以上 | 依赖Google TPU |

| 企业成本 | 开源免费 | 商业授权$10万/年 | 按API调用收费 |

选择指南:

- 写周报/会议纪要 → Phi-4-Mini(离线快+中文强)

- 开发多语言APP → Llama 3-8B(网络语料丰富)

- 科研机构 → Gemma 7B(学术文献优化佳)

🛠️ 落地应用指南

- 小白尝鲜

登录Hugging Face在线版,输入“用鲁迅风格写辞职信”,秒得结果。 - 开发者部署

bash pip install transformers from transformers import AutoModel model = AutoModel.from_pretrained("microsoft/Phi-4-Mini") # 调用本地模型 - 企业集成方案

- 制造业:工厂设备语音指令系统(Phi-4-Multimodal+噪音抑制模块)

- 律师行:合同条款比对工具(利用128K长文本记忆)

💡 避坑建议

- 长文本处理技巧:每处理1万字插入章节摘要,防角色混乱

- 日语场景替代方案:搭配Sakura-13B专用翻译模型补短板

- 医疗影像慎用:优先考虑腾讯觅影等专业工具