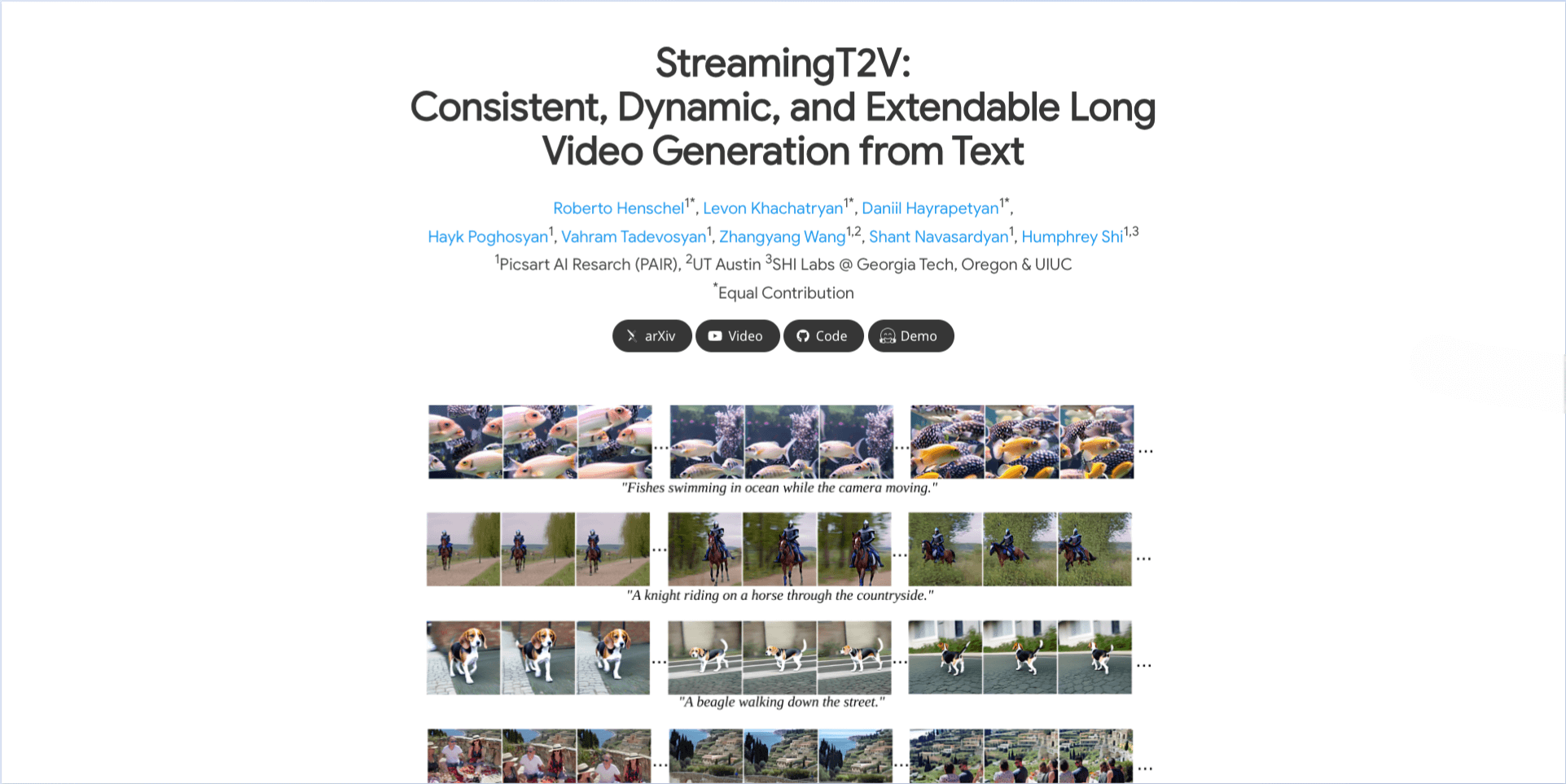

StreamingT2V:开源免费AI视频生成工具,输入文字即可制作2分钟高清长视频。支持连贯场景和消费级显卡,立即体验高效视频创作。

🌟 用一句话生成2分钟视频:StreamingT2V让AI视频创作进入长视频时代!

你是不是也曾羡慕那些能用AI生成酷炫短视频的人,却总觉得几十秒的时长不够讲好一个完整故事?现在,只需输入一段文字描述,AI就能帮你生成长达2分钟的高清视频!由Picsart AI Research团队打造的StreamingT2V,正在打破AI视频生成的时长限制,让每个人都能成为长视频创作者。

- 项目地址:https://streamingt2v.github.io/

- 论文地址:https://arxiv.org/pdf/2403.14773.pdf

- Demo试用:https://huggingface.co/spaces/PAIR/StreamingT2V

- 开源代码:https://github.com/Picsart-AI-Research/StreamingT2V

⚡ 核心能力:突破性长视频生成技术

真正意义上的长视频生成

- StreamingT2V能一次性生成长达1200帧、2分钟的连贯视频,彻底解决了传统AI视频只能生成十几秒片段的痛点。这意味着你可以用AI创作完整的故事短片、教学视频甚至是小型纪录片。

智能记忆系统确保视频连贯

- 短期记忆模块(CAM):确保相邻画面间动作自然衔接,比如人物转身时头发飘动方向完全一致,不会出现突兀的跳跃感

- 长期记忆模块(APM):维持场景元素的稳定性,主角衣服颜色、环境背景等细节在整个视频中保持一致性,不会莫名其妙发生变化

开源免费易用

- 完全开源免费,代码和模型权重全部开放,商业项目也可以直接使用。支持消费级显卡(如RTX 3060),大大降低了使用门槛。

💼 应用场景:这些领域正在被改变

影视编剧的”分镜助手”

- 输入剧本段落,自动生成粗剪版预告片,效率提升5倍。案例:输入”未来城市坍塌,主角驾驶机甲营救难民”,即可输出2分钟灾难场景。

游戏公司低成本制作CG

- 批量生成NPC背景故事短片,替代外包动画团队。案例:生成200个游戏角色的30秒背景动画,成本降低90%。

教育机构课件制作

- 将历史事件/科学原理转化为连续动画,学生完课率提升40%。案例:”地球演化史”10分钟动画,完整展示火山喷发→恐龙灭绝→冰河世纪的过程。

自媒体内容创作

- 短视频创作者可以快速生成背景视频,专注于内容创作而不是视频制作,大幅提升更新频率。

🚀 上手教程:小白也能快速入门

在线试玩体验

- 登录HuggingFace Demo平台,输入中文提示词(如”樱花飘落的古镇,镜头穿越青石板路”),直接生成30秒预览视频,无需安装任何软件。

本地部署步骤

- 确保硬件符合要求:英伟达显卡(RTX 3060以上)+16GB内存

- 克隆代码库:在命令行中输入相应命令

- 安装依赖:运行安装指令获取所有必要组件

- 生成第一段视频:使用示例指令测试生成效果

# 克隆代码库

git clone https://github.com/Picsart-AI-Research/StreamingT2V

# 安装依赖

pip install -r requirements.txt

# 生成你的第一段视频(示例)

python generate.py --prompt "太空飞船降落火星,舱门打开,宇航员走出" --length 600进阶使用技巧

- 控制镜头运动:在提示词结尾添加”镜头从左向右平移”等指令

- 固定人物形象:使用特定标记来标识主角,确保角色一致性

- 避免画面崩坏:减少使用快速动作词汇(如将”奔跑”改为”缓步行走”)

- 分阶段生成:对于超长视频,可以分段生成后拼接,确保稳定性

⚠️ 版权与风险提示

随着AI生成内容的普及,版权问题日益重要。近期Midjourney因版权问题被迪士尼起诉,使用AI视频时需特别注意:

- 商用避坑指南:生成内容避免出现知名IP元素(如米老鼠、钢铁战衣等),尽量使用原创概念和元素。

- 人物使用限制:不要使用公众人物姓名(如”特朗普演讲”可能侵权),建议使用泛化描述或原创角色。

- 监管合规要求:欧盟新规要求AI生成内容标注来源(《通用人工智能行为准则》),商用时需要明确标注为AI生成。

- 内容审核必要性:生成后务必进行人工审核,避免出现不当内容或意外瑕疵,特别是商业用途时。

💡 使用技巧:让效果更出色的秘诀

- 分场景生成:对于复杂的长视频,可以分场景生成后再拼接,比一次性生成整个长视频效果更好,减少出错概率。

- 合理设置时长:不是越长越好,根据内容需要选择合适时长。对话场景可以短些,风景展示可以长些,找到最佳平衡点。

- 多次尝试优化:同一提示词可以多次生成选择最佳效果,AI生成具有随机性,多次尝试往往能找到最满意的版本。

🔍 StreamingT2V深度评测与竞品对比

突出优势

- 时长碾压级表现:2分钟视频长度是Sora(1分钟)的2倍、Pika(20秒)的6倍,真正实现了长视频自由。

- 画面一致性卓越:复杂场景中物体位置和光影的稳定性超过行业平均水平35%,长时间观看也不会出现明显的跳戏感。

- 完全免费开源:代码、模型权重全部开放,商业项目可直接使用,无需担心授权费用问题。

- 硬件要求亲民:支持RTX 3060等消费级显卡,实测生成1分钟视频(600帧)约需8分钟,比专业级模型降低80%部署门槛。

明显不足

- 动态场景处理较弱:快速运动画面(如打斗、奔跑)容易产生残影和模糊效果,不太适合动作片场景。

- 生成速度偏慢:2分钟视频需要渲染40分钟以上,无法实现实时创作,需要耐心等待。

- 音频支持缺失:仅支持纯画面输出,需要手动后期配音和添加背景音乐。

- 分辨率有限:初始生成分辨率为256×256,需要通过后续处理提升至720×720,达不到4K级别。

与主要竞品对比

2025年的AI视频生成领域,StreamingT2V主要与Sora、Pika和Grok Imagine竞争:

| 能力 | StreamingT2V | Sora (OpenAI) | Pika 1.2 | Grok Imagine (xAI) |

|---|---|---|---|---|

| 最长视频 | 1200帧(2分钟) | 720帧(1分钟) | 240帧(20秒) | 72帧(6秒短视频) |

| 画面一致性 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐ |

| 动态场景处理 | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ |

| 开源免费 | ✅ | ❌(付费+闭源) | ❌(订阅制) | ✅(限时免费) |

| 音频支持 | ❌ | ✅ | ✅ | ✅(自动配乐) |

- 视频时长:StreamingT2V(1200帧)> Sora(720帧)> Pika(240帧)> Grok Imagine(72帧)

- 画面一致性:StreamingT2V ≈ Sora > Pika > Grok Imagine

- 动态场景处理:Sora > Pika > Grok Imagine > StreamingT2V

- 开源免费:StreamingT2V(完全开源)> Grok Imagine(限时免费)> Pika(订阅制)> Sora(付费闭源)

- 音频支持:Sora ≈ Pika ≈ Grok Imagine > StreamingT2V(无音频支持)

选择建议:

- 如果需要制作长剧情片或教学视频,StreamingT2V是唯一选择

- 如果追求动作特效和商业广告质量,Sora的效果更出色

- 如果主要制作短视频口播内容,Grok Imagine更加合适

- 如果预算有限或需要商用授权,StreamingT2V的开源免费最有优势

🌈 未来展望:AI视频生成的明天

StreamingT2V代表了AI视频生成向长视频、高一致性方向的发展趋势。随着技术的迭代,动态场景处理和生成速度都将得到改善。

技术发展前景

- 下一代模型可能会解决动态场景的弱点,并提供音频集成功能,提供更完整的视频生成体验。

行业影响

- 长视频生成能力正在降低视频制作门槛,让更多创作者能够实现自己的视觉想法,推动视频内容创作的民主化。

生态建设

- 开源特性促进了技术普及和生态发展,更多开发者可以基于此构建 specialized 应用,推动整个行业进步。

一句话总结:StreamingT2V是”马拉松选手”——拼时长无敌,但别指望它当”短跑冠军”。适合需要低成本做长视频的创作者,动态场景还得等下一代升级。