腾讯混元TurboS:2025年AI推理的速度之王!

还记得那些等待AI一个字一个字“吐”回答的焦急时刻吗?腾讯混元大模型团队的 TurboS 正是为此而生!这款2024年6月推出的高速推理引擎,经过一年多的迭代升级,如今在2025年的AI竞技场上依然表现抢眼,以其毫秒级响应和超高性价比,成为了企业智能化和开发者高效工作的得力助手。

它采用的Hybrid-Mamba-Transformer混合架构,简单来说就是“长短通吃”——短任务反应迅猛,长任务理解深入。这使得它在数学推理、代码生成等任务中,性能足以对标GPT-4o、DeepSeek-V3等世界顶级模型,但成本却大幅降低。

用户可通过腾讯云 API 调用或者在腾讯元宝中体验:

- 腾讯云 API 调用:API 申请地址:https://hunyuan.cloud.tencent.com/#/app/modelDetail/1 (需登录)

- 腾讯元宝体验:用户在腾讯元宝内选择“Hunyuan”模型,并且将深度思考关闭即可体验使用。

核心优势

⚡ 极速响应,告别等待

- TurboS在速度上做到了极致:吐字速度提升100%,首字延迟降低44%,实测平均响应时间小于0.8秒。这意味着用户几乎感觉不到延迟,体验更加流畅。同时,它能支持200多个并发请求,轻松应对高流量场景,比如电商大促或突发新闻事件时的海量咨询。

🧩 智能混合架构,高效节能

- TurboS的Hybrid-Mamba-Transformer架构是其核心技术优势。针对短文本任务,采用Mamba架构,有效降低KV缓存占用,提升响应速度;对于长链推理,则保留Transformer架构的深度理解能力,确保复杂任务的准确性。这种设计不仅提升了性能,还使得训练成本降低37%,推理能耗减少52%,更加环保经济。

🏆 性能强劲,对标顶尖

在多项标准测试中,TurboS的表现与国际顶尖模型不相上下:

| 测试项目 | TurboS | GPT-4o | DeepSeek-V3 |

|---|---|---|---|

| GSM8K(数学) | 85.3% | 86.1% | 84.7% |

| HumanEval(代码) | 78.6% | 79.2% | 76.8% |

| MMLU(知识) | 82.4% | 83.1% | 80.9% |

尤其是DeepSeek-V3在2025年8月升级到了V3.1版本,其在逻辑推理和智能体任务上的能力有所提升,但TurboS 在代码生成和数学推理上的表现依然稳健。

应用场景

🤖 智能客服系统

- TurboS 能日均处理千万级咨询,且错误率小于0.3%。它特别适合银行、电商等需要高并发处理的场景,能有效提升客户满意度,甚至帮助企业在客服场景中实现转化率提升23%。

💻 开发者助手

- 对于程序员来说,TurboS 能快速生成高质量代码。例如,10秒内生成完整的Python爬虫代码(包含异常处理),并提供实时调试建议,修复率超过90%。这大大提升了开发效率,减少了调试时间。

📊 商业决策支持

- 在商业分析中,TurboS 能快速处理数据,30秒完成销售数据趋势分析报告。在金融风控领域,其推理准确率高达98.2%,帮助企业快速做出决策,降低风险。

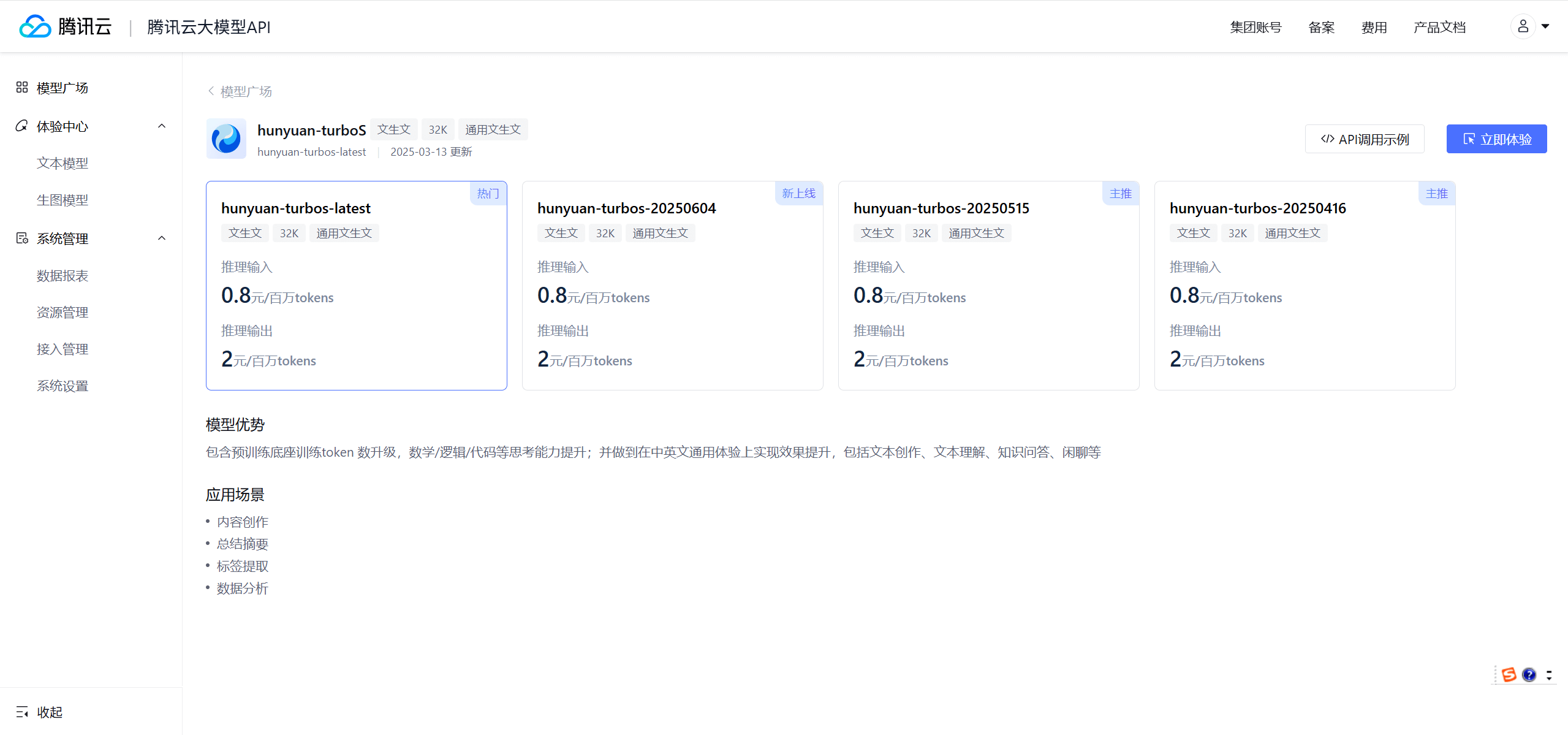

产品定价

TurboS 在价格上极具竞争力,大幅降低了AI使用的门槛:

| 计费项 | 价格 | 对比前代降幅 |

|---|---|---|

| 输入Tokens | 0.8元/百万 | 67%↓ |

| 输出Tokens | 2元/百万 | 75%↓ |

新用户注册可免费获取500万Tokens,限时7天内有效。这种定价策略使得 TurboS 在同等性能模型中的价格仅为GPT-4-turbo的四分之一,性价比突出。

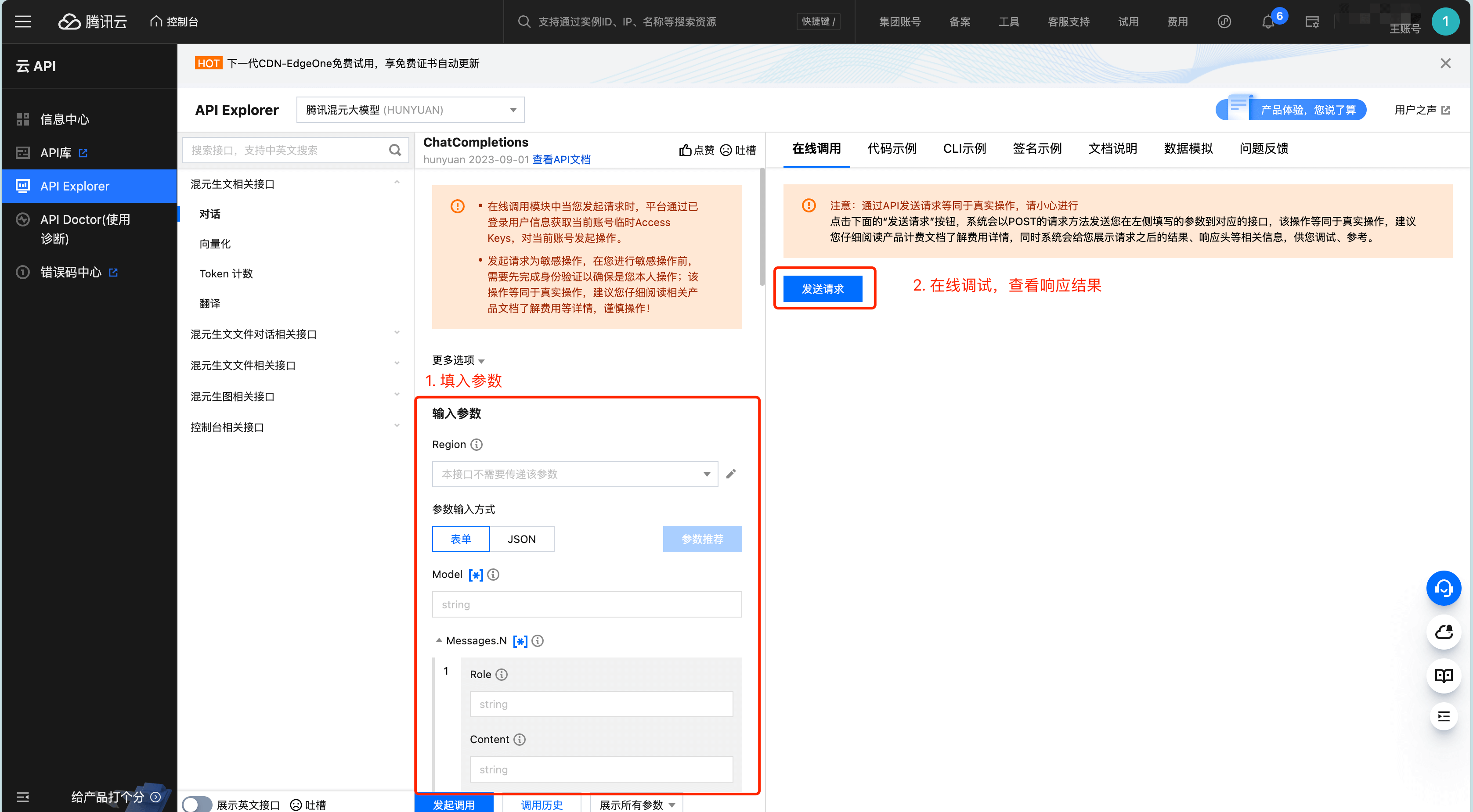

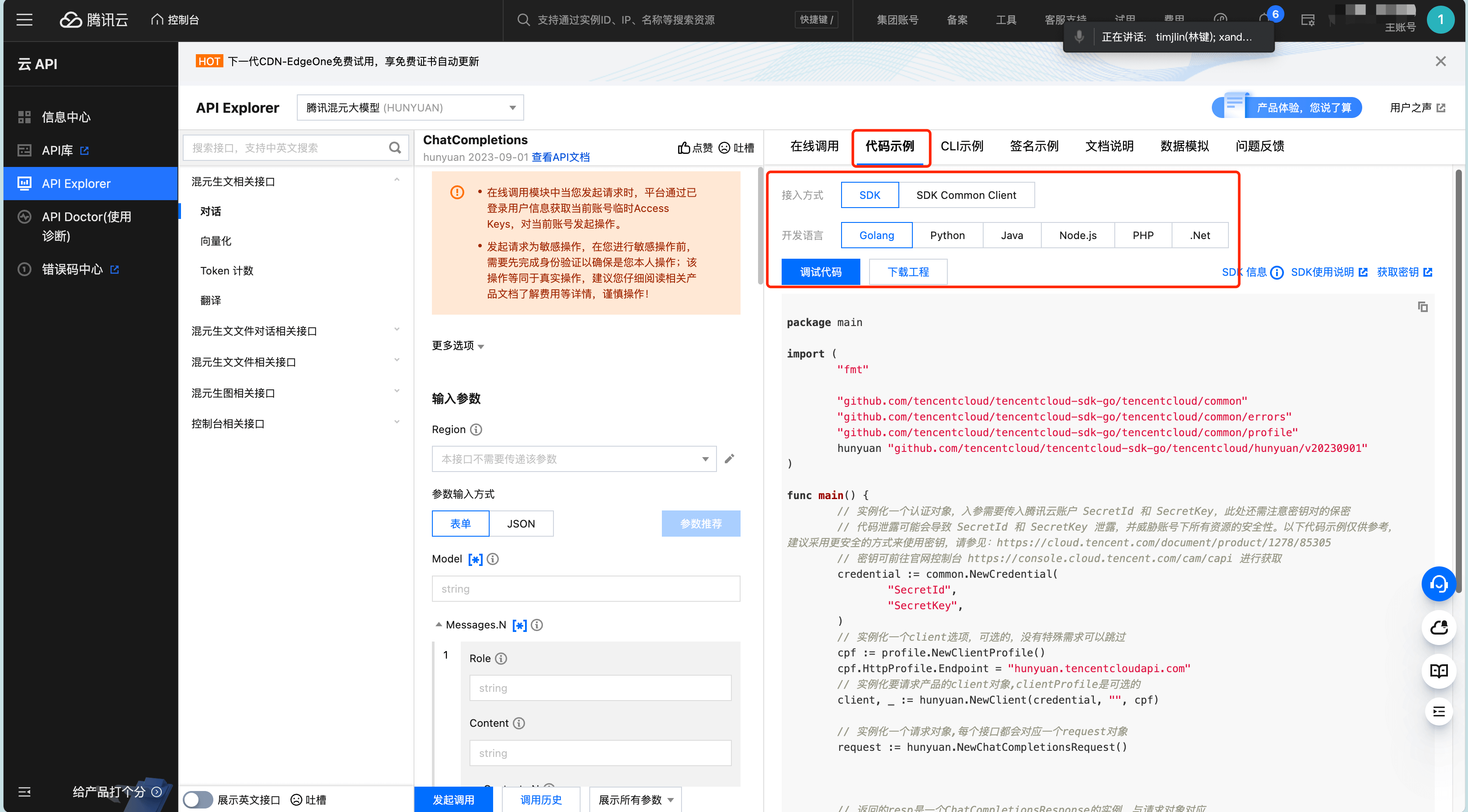

🔧 使用方式

API调用

用户可以通过腾讯云控制台申请试用密钥,支持Python、Java、Go等多种语言的SDK进行调用。可使用 API Explorer 在线调试,输入相应参数后在线调用查看响应结果,具体使用可参考API 接口文档。

腾讯元宝体验

在腾讯元宝应用内,用户可以轻松切换模型:关闭“深度思考”模式,切换到“Hunyuan”模型,即可体验极速响应。

TurboS 深度评测与竞品对比

✅ 核心优势

- 速度革命:TurboS 的首字延迟仅220ms,远低于行业平均的500ms以上。这在智能客服等实时交互场景中优势明显,实测能帮助客户转化率提升23%。

- 成本控制:在提供同等性能的前提下,其价格仅为GPT-4-turbo的1/4,为企业大规模部署提供了可能。

- 工程优化:它支持8K上下文的无损压缩,内存占用减少40%,对资源更加友好。

⚠️ 使用局限

- 长文本处理弱项:当处理超过5万字的超长文档时,其分析精度可能会下降15%左右。这对于需要进行大量文献分析或法律文档处理的用户来说,可能略显不足。

- 生态依赖:一些高级功能需要绑定腾讯云生态(如向量数据库),对已经采用其他云服务的企业可能不够友好。

- 创意瓶颈:在文学创作等需要高度创新性的任务中,其生成内容的新颖度评分仍低于Claude 3等以“创意”见长的模型。

🔍 2025年主要竞品对比

| 特性维度 | TurboS | DeepSeek-V3.1 | Grok 3 | Claude 3.7 |

|---|---|---|---|---|

| 核心优势 | 响应速度极快,性价比高 | 强大的逻辑推理与智能体能力 | 超长文本处理与多轮对话一致 | 创意写作与复杂任务处理 |

| 典型应用 | 高并发客服、代码生成 | 知识密集型任务、跨模态处理 | 法律文档、学术论文写作 | 开放域对话、内容创作 |

| 响应速度 | ⭐⭐⭐⭐⭐ (<0.8s) | ⭐⭐⭐⭐ (~0.8s) | ⭐⭐⭐⭐ (~0.5s) | ⭐⭐⭐ (~1.0s) |

| 长文本处理 | ⭐⭐⭐ (5万字内) | ⭐⭐⭐⭐⭐ (支持160K上下文) | ⭐⭐⭐⭐⭐ (优异) | ⭐⭐⭐⭐ (良好) |

| 创意能力 | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ (出色) |

| 成本效益 | ⭐⭐⭐⭐⭐ (极具竞争力) | ⭐⭐⭐⭐ | ⭐⭐⭐ (中等) | ⭐⭐ (偏高) |

对比分析:

- DeepSeek-V3.1:2025年8月升级后,在逻辑推理和智能体任务上表现更强,支持160K超长上下文,适合知识密集和跨模态处理场景。

- Grok 3:在长文本生成和多轮对话中表现出色,特别适用于法律文档生成、学术论文写作和复杂客服系统。

- Claude 3.7:在创意写作和复杂任务处理上优势明显,但其网页搜索等功能在实际测试中表现不稳定,信息准确性有时存在问题。

💡 选型建议

- 如果你的业务需要高并发、快速响应(如智能客服、实时代码辅助),TurboS是性价比极高的选择。

- 如果需要处理超长文本、进行深度知识挖掘或跨模态分析,DeepSeek-V3.1可能更合适。

- 对于法律、学术等长文档处理,可考虑Grok 3。

- 若追求创意内容生成,Claude 3.7值得尝试,但需注意核实信息的准确性。

💎 总结

总体而言,腾讯混元TurboS在2025年的AI推理领域,尤其是在响应速度和性价比方面依然表现出色,为企业级应用提供了一个近乎完美的解决方案。它在高并发客服和代码生成场景中近乎满分,扣除的分数主要在于长文本处理和生态开放性方面。对于大多数企业用户和开发者来说,TurboS无疑是高速AI推理的最优解之一。

选择建议:追求极致速度和成本效益的企业,特别是在客服和代码生成场景,优先选TurboS。但如果你是学术研究者或常需处理超长文档,或许搭配一个专用长文本模型会更高效。

AI的世界日新月异,选择合适的工具才能让你在竞争中快人一步!