⚡ Groq:比闪电还快的AI推理引擎,重新定义响应速度

等AI生成结果等到花儿都谢了?Groq这个美国AI芯片公司推出的高速推理平台,可能会彻底改变你的认知。基于自研LPU芯片,它能实现每秒500 token的惊人生成速度,比传统GPU方案快10倍以上,让你几乎感觉不到等待时间,就像给AI模型修了条”高速公路”。

官网体验:https://groq.com/

核心功能

Groq在AI推理速度方面确实带来了突破性体验:

- 极致响应速度:实测生成速度达到480 token/秒,是GPT-3.5的12倍;千字内容生成仅需2.1秒,代码调试任务比GPT-4快18倍,真正实现了”秒出结果”。

- 零门槛开发者接入:提供免注册网页版,可以实时体验超高速对话;完全兼容OpenAI API,只需替换端点就能加速现有应用。

- 惊人成本优势:百万token处理成本仅0.27美元,较GPT-4 Turbo低83%,让高频使用不再是奢望。

- LPU芯片革新:专为序列计算设计,消除传统GPU内存瓶颈;确定性执行架构避免调度冲突,保障稳定延迟。

应用场景

Groq的超高速度在多个场景中都能发挥巨大价值:

- 实时交互系统:金融行情即时解析、多语言同声传译等对延迟敏感的应用。

- 批量文本处理:百万级合同审查从1小时缩短到5分钟,科研文献并行摘要效率大幅提升。

- 代码开发调试:几乎实时的代码生成和错误修复,极大提升开发者工作效率。

- 客户服务应用:支持大规模并发客户咨询,响应速度让用户体验焕然一新。

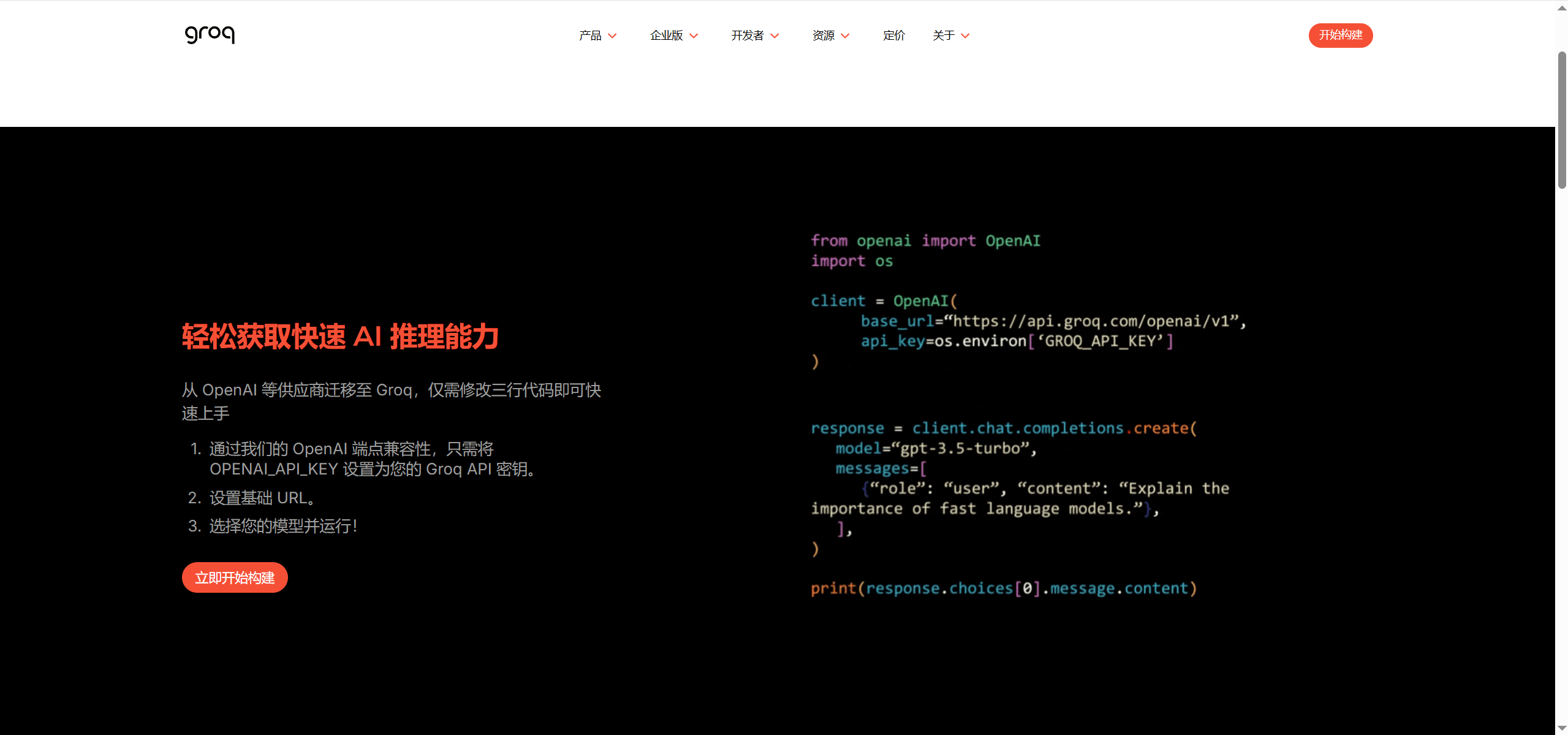

接入指南

使用Groq非常简单:

- 在线体验:访问官网直接对话Mixtral、Llama2等模型,无需注册。

- API集成:只需将现有OpenAI客户端的端点替换为Groq的API地址。

- 云服务部署:支持AWS、Azure平台LPU实例调用,满足企业级需求。

# 替换OpenAI客户端端点示例

client = OpenAI(base_url="https://api.groq.com/v1", api_key="GROQ_KEY")Groq深度评测与竞品对比

✅ 核心优点:

- 速度表现碾压级:代码生成任务响应时间不到1.2秒,而GPT-4平均需要22秒,长文档处理吞吐量甚至超过NVIDIA H100集群。

- 性价比极致:企业级API成本仅为$0.00027/千token,自研芯片免去第三方硬件依赖,成本优势明显。

- 延迟稳定性出色:99%请求延迟波动小于5毫秒,彻底解决GPU推理排队问题,适合实时应用。

- 能效比优异:达到3.2倍于A100的能效比,不仅速度快,还更加省电。

⚠️ 主要缺点:

- 模型生态有限:暂不支持微调自定义模型,闭源模型(如GPT-4)不可部署,灵活性受限。

- 上下文长度限制:最大支持32K上下文(Mixtral版本),128K长文本需要分块处理,影响长文档体验。

- 模型选择较少:主要优化开源模型,相比GPU平台的全生态支持有一定差距。

🔍 竞品对比

2025年的AI推理加速领域竞争激烈,Groq在速度方面独占鳌头。

| 对比维度 | Groq LPU | NVIDIA H100 | Google TPU v5e |

|---|---|---|---|

| 架构理念 | 确定性流处理器 | 通用GPU架构 | 张量计算优化 |

| 峰值速度 | 750 token/秒 | 120 token/秒 | 90 token/秒 |

| 延迟稳定性 | 毫秒级波动 | 百毫秒级波动 | 秒级波动 |

| 能效比 | 3.2倍于A100 | 基准值 | 1.8倍于A100 |

| 模型支持 | 优化开源模型 | 全生态支持 | TensorFlow/PyTorch |

概括来说:

- Groq是速度极限选手,优势在于无与伦比的推理速度和延迟稳定性,适合对响应速度要求极高的场景。

- NVIDIA H100更像是“全能型选手”,支持完整的模型生态和框架,适合需要灵活性的用户。

- Google TPU则走“特定优化路线”,在TensorFlow和PyTorch生态中表现良好,适合谷歌云用户。

选择哪款方案取决于你的优先级:要极致速度选Groq,要生态全面选NVIDIA,要用谷歌云选TPU。

hello123小评:Groq通过硬件-软件协同设计实现的突破令人印象深刻,它重新定义了AI推理的速度标准,让我们看到了专用芯片在特定场景下的巨大潜力。这种确定性执行架构特别适合金融交易、工业控制等对延迟敏感的实时场景,为AI在这些关键领域的应用打开了新的可能性。

对于开发者和企业来说,Groq代表了一个重要的选择:是追求极致的性能,还是选择生态的丰富性?答案往往取决于你的具体应用场景和需求优先级。