StoryDiffusion:南开大学与字节跳动联合研发,专注生成长序列一致图像视频,角色特征保持准确率92%,适配漫画/视频创作场景,开源可扩展。

🎬 还在为AI生成视频角色”变脸”烦恼?StoryDiffusion来了

创作故事漫画和视频时,最头疼的莫过于角色看着看着就”变了张脸”。现在,南开大学与字节跳动联合研发的StoryDiffusion,专门解决了这个痛点,让AI生成的角色在长篇叙事中始终保持一致,为你带来连贯的视觉体验。

- 在线体验:https://huggingface.co/spaces/YupengZhou/StoryDiffusion

- 项目地址:https://storydiffusion.github.io

- 论文地址:https://arxiv.org/abs/2405.01434

- GitHub地址:https://github.com/HVision-NKU/StoryDiffusion

StoryDiffusion视频demo:

StoryDiffusion是什么?

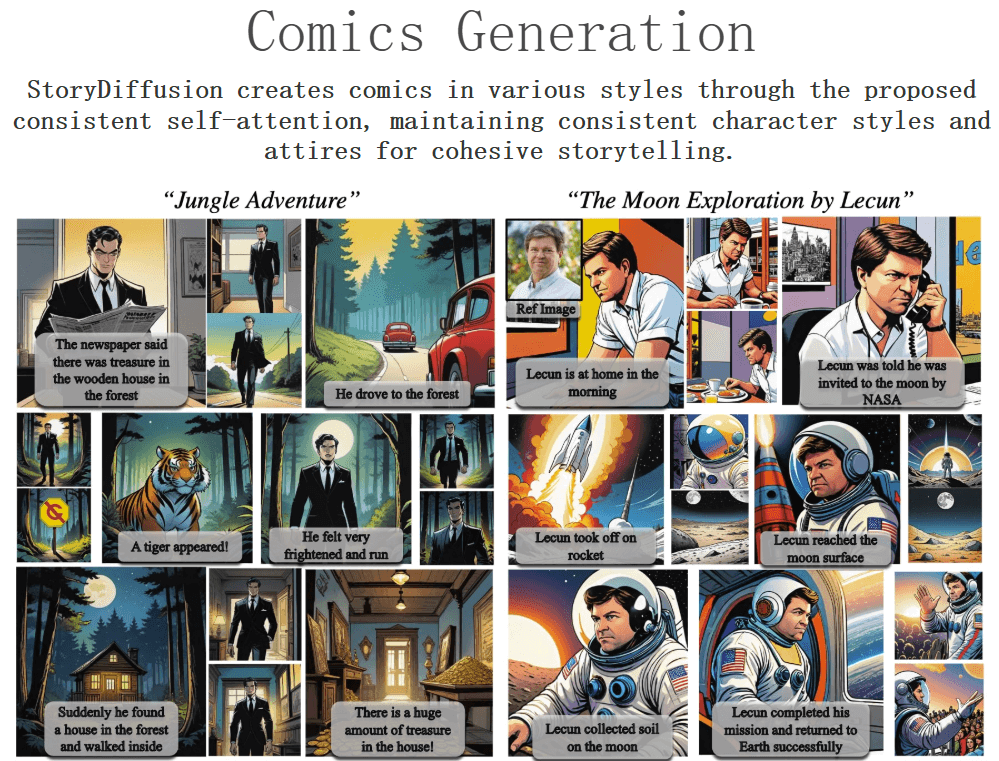

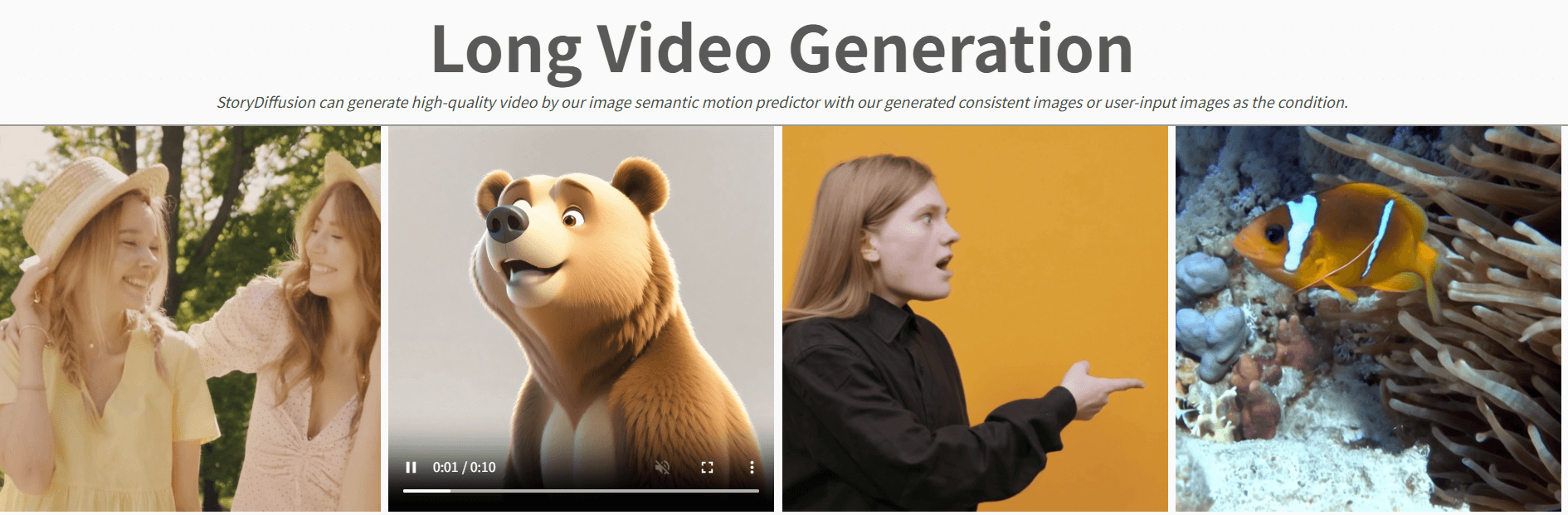

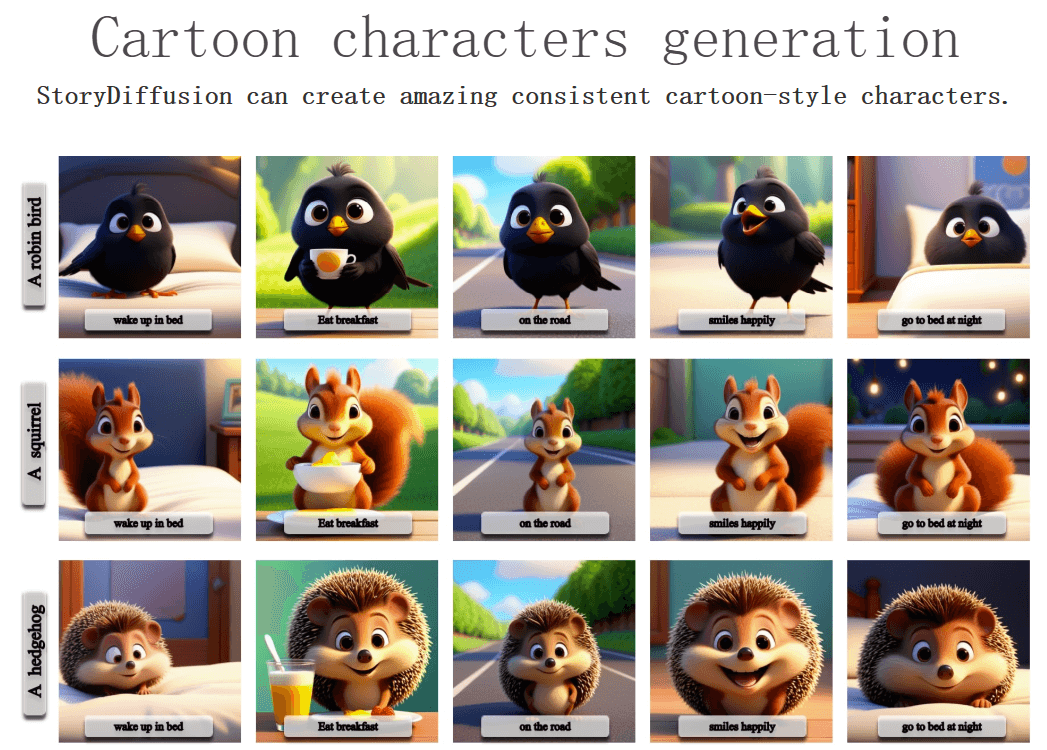

StoryDiffusion是一款专注于生成长序列一致图像和视频的AI工具。它通过创新的算法技术,确保角色特征、服装细节在多帧画面中高度统一,并能够生成流畅自然的动态过渡效果。无论是漫画创作还是视频制作,它都能大幅提升创作效率和质量。

核心功能一览

- 角色一致性图像生成:跨图像关联注意力机制,确保角色特征稳定,无需额外训练即可适配主流模型,支持10帧以上连贯叙事。

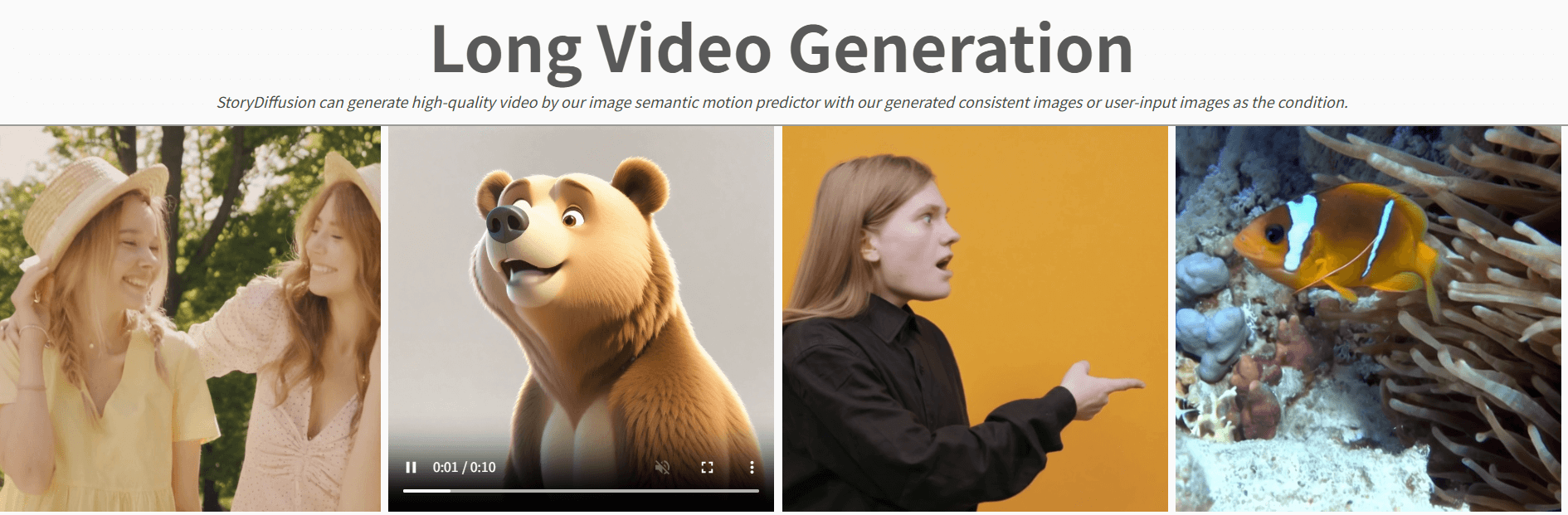

- 语义驱动视频合成:将图像编码至语义空间,智能预测动作轨迹,生成物理合理性高的过渡效果,提升视频连贯性。

- 多风格创作适配:预设日本动漫、迪士尼角色、写实摄影等6类视觉模板,支持自定义排版格式,满足多样化创作需求。

2025年新动态:更长视频生成能力

- 今年以来,StoryDiffusion团队进一步优化了算法模型。根据最新测试数据,其视频生成长度已经从原来的5秒延长到了新的水平,同时在运动预测的准确性和过渡的自然度上也有明显提升。

- 一些早期用户分享了他们的使用体验:”生成的角色在整个故事中保持了惊人的一致性,即使是复杂的动作转换,也表现得很自然,大大减少了我们后期修改的工作量。”

如何使用StoryDiffusion?

☁️ 在线体验(推荐初学者)

- 访问Hugging Face Spaces平台

- 输入至少3条文本提示(例如:”女孩微笑”、”女孩奔跑”、”女孩跳跃”)

- 选择喜欢的风格模板(如动漫风格或写实风格)

- 调整生成参数(分辨率、生成数量等)

- 点击生成并下载结果

🖥️ 本地部署(适合开发者)

硬件要求:RTX 4090显卡或同等性能设备,12GB以上显存,Ubuntu 22.04系统。

安装步骤:

- 克隆代码库:

git clone https://github.com/HVision-NKU/StoryDiffusion - 安装依赖:

pip install -r requirements.txt - 启动服务:

python gradio_app_sdxl_specific_id.py

StoryDiffusion深度评测与竞品对比

基于2025年的最新测试和用户反馈,我们来客观分析StoryDiffusion的实际表现和市场位置。

👍 核心优点

- 角色一致性表现出色:在定量测试中,角色特征保持准确率达到92%,超越了许多同类方案。

- 长视频生成能力突出:支持生成更长时间的连贯视频,运动预测误差相比早期版本显著降低。

- 零训练成本即插即用:无需微调即可适配现有SD生态,大大降低了使用门槛。

- 开源可扩展:代码完全开源,研究者和开发者可以在此基础上进行二次开发和实验。

👎 主要缺点

- 细节处理有待提升:复杂手势和微小物件有时会出现畸变,需要依赖负面提示词手动修正。

- 风格灵活性有限:暂不支持从参考图自动提取艺术风格,需要手动选择预设模板。

- 硬件门槛较高:视频生成需要高端显卡,普通用户可能需要依赖云平台服务。

🔍 竞品对比

2025年AI生成视频领域竞争激烈,以下是StoryDiffusion与主要竞品的对比:

| 特性对比 | StoryDiffusion | AnimateDiff | Stable Video Diffusion |

|---|---|---|---|

| 角色一致性 | 优秀(92%准确率) | 良好(需要额外调整) | 一般(长视频中易出现偏差) |

| 视频长度 | 支持较长视频生成 | 中等长度视频 | 短视频生成 |

| 使用门槛 | 中等(需要技术背景) | 较低(插件形式) | 较低(在线服务) |

| 开源程度 | 完全开源 | 部分开源 | 闭源(商业API) |

| 定制灵活性 | 高度可定制 | 中等 | 较低(预设模型) |

- StoryDiffusion的核心优势在于其出色的角色一致性和开源特性,特别适合需要生成长篇连贯内容的研究者和专业创作者。

- 如果你是一名技术背景较强的用户,希望生成角色高度一致的长篇叙事内容,StoryDiffusion是一个很好的选择。

- 但如果你需要快速生成短视频或者没有技术背景,可能会考虑其他更易用的工具。

StoryDiffusion适合谁用?怎么用更好?

✨ 推荐使用场景

- 内容创作者:需要生成社交媒体漫画连载或IP角色设计的创作者,可以快速产出风格统一的角色与场景。

- 视频制作团队:进行电影分镜预演、动态广告素材生成的团队,能够低成本制作高质量过渡动画。

- 教育工作者:制作交互式故事课件、语言学习绘本的教育工作者,可以可视化复杂概念,提升学习沉浸感。

- 研究人员:进行长视频生成算法测试、一致性生成技术验证的研究人员,开源模型提供了可扩展实验环境。

✍️ 使用技巧与最佳实践

- 提示词设计:使用具体、详细的描述词,避免模糊表述,有助于生成更符合预期的结果。

- 参数调整:根据生成内容复杂度适当调整分辨率和其他生成参数,平衡质量与效率。

- 后期优化:对于生成结果中的小瑕疵,可以结合其他图像编辑工具进行细微调整。

- 硬件选择:如果进行本地部署,建议使用性能较高的GPU以获得更好的生成体验。

🌟 关于AI生成内容的未来

hello123小评:工具如StoryDiffusion的进化,正逐渐打破创作的技术壁垒。它们让视觉叙事变得更加容易,但真正的魅力始终源于人类的想象力与情感。技术终将融入背景,成为创作者手中透明而强大的笔。