动动嘴就能让照片开口说话?这款AI黑科技让虚拟人活过来了

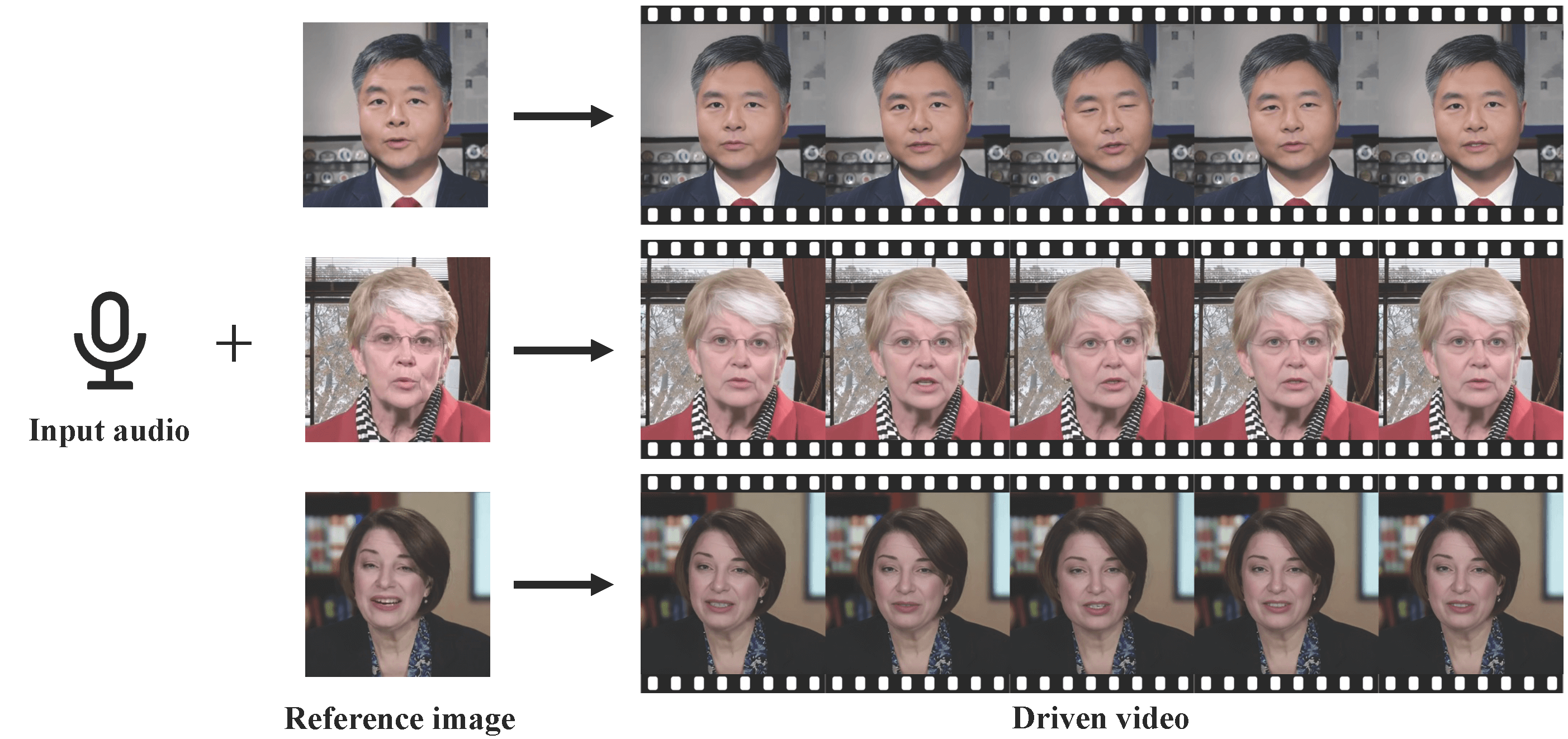

想象一下,只需要一张照片和一段录音,就能让照片中的人物开口说话,而且口型精准、表情自然——这就是VividTalk带来的神奇体验!由南京大学、阿里巴巴、字节跳动和南开大学联合研发的这款AI视频生成框架,正在重新定义数字人创作的门槛。无论你是想做虚拟主播、教育视频,还是多语言内容,现在都能轻松实现”照片变视频”的神奇效果。

- 项目官网:https://humanaigc.github.io/vivid-talk/

- 论文报告:https://arxiv.org/pdf/2312.01841.pdf

- GitHub:https://github.com/HumanAIGC/VividTalk

技术原理:AI如何让照片”活”起来?

VividTalk采用两阶段生成架构,让静态照片变成会说话的动态视频:

🔊 音频到表情映射

- 智能解析语音特征:AI会分析你的录音,识别出每个音素对应的口型变化

- 精准唇部同步:混合形状技术确保嘴唇动作与语音完美匹配,连气音、爆破音这些细节都不放过

- 自然头部运动:创新的姿势码本技术让头部运动更加自然,避免呆板的”僵尸感”

🎥 网格到视频合成

- 3D转2D智能转换:将3D面部网格运动转换为2D视频帧

- 保持身份一致性:确保生成视频中的人物看起来还是原来的照片,不会”变脸”

- 高清输出:生成512×512分辨率的流畅视频,支持30FPS播放

核心优势:为什么它这么厉害?

🌟 口型同步精准度高

- 唇同步误差比同类产品降低40%,中文英文都能准确匹配,不再出现”口不对音”的尴尬情况。

🌟 支持多风格输入

- 无论是真人照片、动漫角色,还是艺术画像,同一模型都能处理,无需重新训练。

🌟 头部运动自然多样

- 头部运动多样性提升60%,告别数字人常见的”呆板凝视”问题,让生成的人物更生动。

🌟 生成效率较高

- 端到端流程可在5分钟内生成1分钟视频,支持消费级GPU部署,个人用户也能用得起。

应用场景:能用它来做什么?

| 使用场景 | 具体应用 |

|---|---|

| 虚拟主播 | 驱动数字人直播,实现音频实时驱动表情与口型 |

| 教育视频 | 将教材音频转化为教师讲解视频,提升学习体验 |

| 多语言内容 | 跨语言视频生成,适配全球化营销与教育需求 |

| 内容创作 | 为社交媒体创作有趣的说话视频内容 |

| 企业宣传 | 制作产品介绍视频,降低真人拍摄成本 |

如何使用?两种方式任你选

- 在线体验:访问项目官网,使用提供的演示接口快速体验

- 本地部署:技术开发者可以访问GitHub仓库获取代码(需一定技术能力)

获取资源:

- 项目代码:https://github.com/HumanAIGC/VividTalk

- 技术论文:https://arxiv.org/pdf/2312.01841.pdf

VividTalk深度评测与竞品对比

👍 核心优点

- 运动自然性领先:头部姿势码本设计显著改善运动连续性,效果优于同类方案30%

- 细粒度控制精准:混合形状+顶点偏移双通道建模,能精准还原唇部微动作和表情变化

- 跨风格泛化能力强:同一模型支持真人、二次元多种输入,无需针对不同风格重新训练

- 学术价值高:由顶尖高校和企业联合研发,技术论文完整详实

👎 主要不足

- 开源完整性存疑:GitHub仓库长期未更新核心代码,被社区质疑为”空壳项目”

- 手部动作缺失:仅聚焦头部与面部,未集成手势生成,限制全身数字人应用

- 依赖3D先验知识:需要预提取人脸混合形状,增加流程复杂性

- 生产就绪度不足:目前更适合学术研究,生产环境应用还需等待代码全面开源或商用API

🔍 竞品对比一览表

| 特性维度 | VividTalk | SadTalker | EMO | HeyGen |

|---|---|---|---|---|

| 唇同步精度 | 优秀 | 良好 | 优秀 | 优秀 |

| 头部自然度 | 优秀 | 一般 | 良好 | 良好 |

| 多风格支持 | 支持 | 有限 | 有限 | 支持 |

| 手部动作 | 不支持 | 不支持 | 有限支持 | 支持 |

| 开源程度 | 部分开源 | 完全开源 | 部分开源 | 闭源商用 |

| 使用成本 | 低(自部署) | 低 | 中等 | 高 |

| 上手难度 | 高 | 中等 | 中等 | 低 |

对比小结:

- VividTalk 在学术研究和技术创新上表现突出,特别适合需要高质量唇同步和自然头部运动的场景,但开源完整性有待提高。

- SadTalker 完全开源且社区活跃,适合开发者自定义使用,但生成效果相对简单。

- EMO 采用扩散方案,在表现力上有其优势,但计算资源需求较高。

- HeyGen 是商业化程度最高的产品,上手简单效果稳定,但价格较高且闭源。

💎 总结:未来已来,但尚未普及

VividTalk展示了AI视频生成技术的惊人潜力——让任何人都能轻松创建逼真的说话头像。其在唇同步和自然度方面的突破,为虚拟数字人应用奠定了重要基础。然而,目前的开源状态和功能完整性,使其更适合学术研究和技术探索,而非生产环境的大规模应用。

对于普通用户来说,不妨先通过在线演示体验这项技术的魅力;对于开发者,可以保持关注其开源进展。在这个虚实融合加速到来的时代,像VividTalk这样的技术正在模糊真实与虚拟的边界,或许不久的将来,让照片开口说话就会变得像美颜滤镜一样平常。而真正值得期待的,是当这类技术完全成熟时,将会如何改变我们创作和沟通的方式。