-

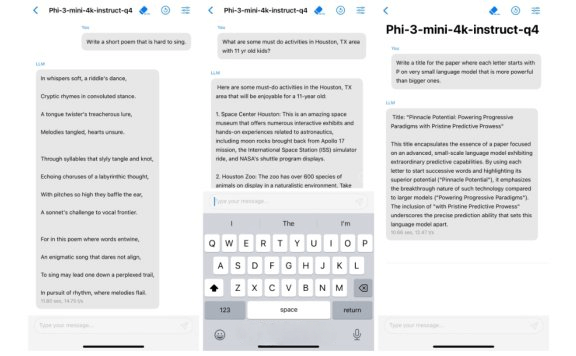

Phi-3:微软推出的开源小型语言模型,支持移动设备

Phi-3 是微软 AI 研究院开发的一系列小型语言模型,它们是开源的并且可以商用。这些模型的特点是体积小、所需资源少,使得它们能够在资源受限的环境中运行,例如在移动设备或者边缘计算设备上。 -

Genie-谷歌发布的AI基础世界模型,一张图片生成交互世界

Genie是由谷歌发布的根据互联网视频训练的基础世界模型,该模型参数规模为11B,可以从合成图像、照片甚至草图生成无数种动作可控的交互式环境。 -

天工SkyMusic-昆仑万维推出的AI音乐生成大模型

「天工SkyMusic」是昆仑万维推出的AI音乐生成大模型,基于昆仑万维「天工3.0」超级大模型打造,是目前国内唯一公开可用的AI音乐生成大模型。具备高质量音乐制作、逼真人声合成、精准歌词控制、多元风格适应及复杂歌唱技巧学习等五大特点。该模型基于先进的Transformer技术,能够根据用户输入生成具有丰富情感表达的音乐作品,旨在推动音乐创作的创新和个性化发展。 -

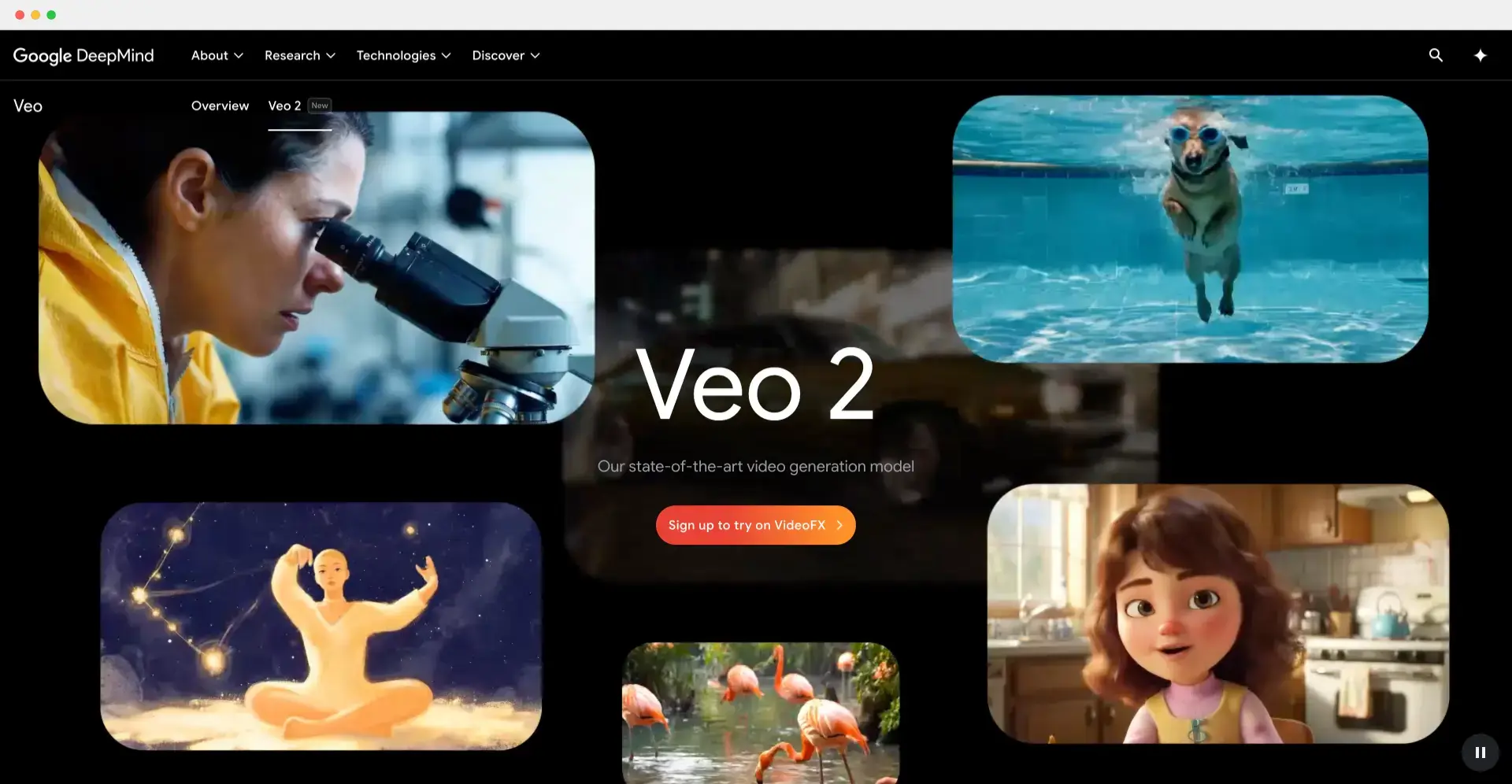

Veo 2:谷歌推出的最新AI视频生成模型,支持生成4k高清视频

Veo 2 是由 Google DeepMind 推出的最新视频生成模型,通过用户的文本提示生成高质量的视频片段,支持分辨率高达4K。Veo 2 的核心技术结合了 AI 对视觉内容的深度理解,能够生成符合指定风格和内容的视频,广泛应用于创意设计和内容创作领域。 -

-

文心大模型X1:百度推出的新一代深度思考模型

文心大模型X1是百度发布的新一代深度思考模型,具备强大的理解、规划、反思和进化能力,支持多模态输入输出以及多种工具调用。它在中文知识问答、文学创作、复杂计算等方面表现出色,性能对标DeepSeek-R1,但API调用价格仅为一半。 -

华知大模型-同方知网携手华为推出的中华知识大模型

华知大模型是同方知网携手华为共同打造内容权威可信、全栈自主可控的专注于知识服务与科研行业的中华知识大模型,旨在覆盖政企文教等多个行业场景,并提供30多项通用能力体系。 -

Llama 3.2:Meta最新推出的开源模型,包括视觉大语言模型和设备端纯文本模型

Llama 3.1是Meta最新推出的开源大语言模型,包括90B和11B两种参数规格的视觉大语言模型,还有能在设备端本地运行的1B和3B轻量级纯文本模型,包括预训练和指令调整版。1B和3B模型支持128K tokens上下文,适配高通和联发科硬件,并针对Arm处理器做了优化。 -

Codestral 25.01:Mistral AI最新推出的AI编程模型,编程速度提高2倍

Codestral 25.01是由Mistral AI推出的一款先进的AI编程模型,旨在显著提升软件开发的效率和质量。作为今年早些时候发布的Codestral的升级版本,Codestral 25.01在架构和分词器上进行了优化,生成和补全代码的速度提升了约2倍。它支持超过80种编程语言,特别适用于低延迟、高频率的使用场景,如代码填充(FIM)、代码修正和测试生成。 -

-

dots.llm1:小红书开源的 MoE 架构大语言模型

dots.llm1是小红书开源的 MoE 架构大语言模型,拥有 1420 亿参数,推理仅激活 140 亿,兼顾性能与效率。模型基于 11.2 万亿非合成高质量数据训练,支持中英文,具备 32K 长上下文处理能力,并开放中间训练 checkpoint,适合问答、内容生成、语义理解等多种应用场景。 -

GLM-Realtime:智谱最新推出的端到端AI模型,支持2分钟记忆和清唱功能

GLM-Realtime是由智谱推出的低延迟端到端多模态模型,具备视频理解、语音交互、内容记忆、清唱功能和 Function Call 功能。它适用于多种实时交互场景,通过 Function Call 功能可以拓展到更广泛的商业应用。开发者可以免费调用该模型,体验其强大的实时交互能力。 -

TransGPT:国内首个综合交通大模型

TransGPT是国内首款开源交通大模型,主要致力于在真实交通行业中发挥实际价值。它能够实现交通情况预测、智能咨询助手、公共交通服务、交通规划设计、交通安全教育、协助管理、交通事故报告和分析、自动驾驶辅助系统等功能。 -

Qwen2-Audio:阿里推出的开源音频语言大模型

Qwen2-Audio是由阿里通义团队推出的大型音频语言模型系列,它能够接受音频信号输入,进行音频分析或直接文本响应,支持语音聊天和音频分析两种交互模式,并且提供了预训练模型Qwen2-Audio-7B和聊天模型Qwen2-Audio-7B-Instruct的版本。 -

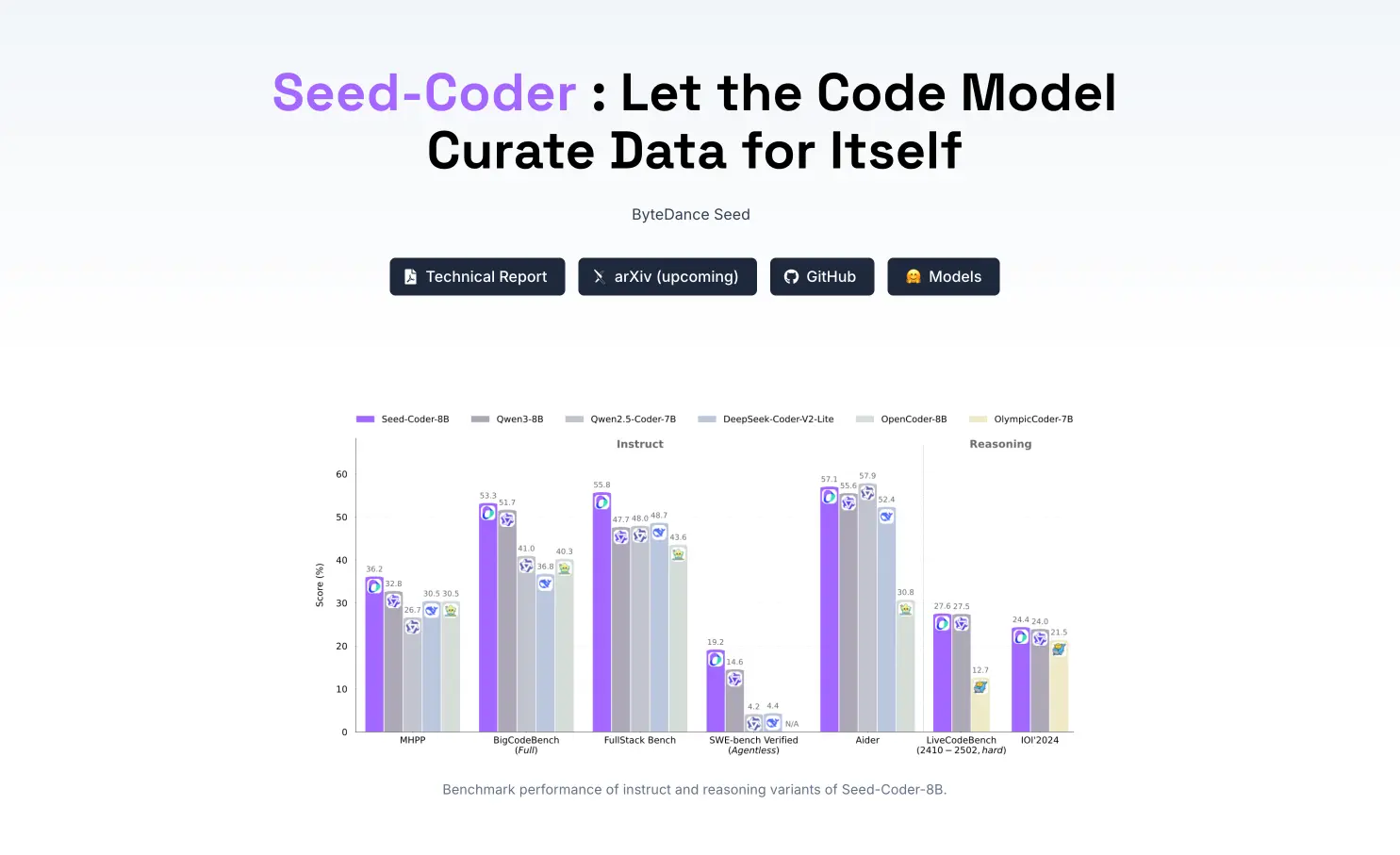

Seed-Coder:字节跳动最新推出的开源代码模型

Seed-Coder 是字节跳动开源的 8B(80亿参数)级代码大模型,它包括 Base、Instruct 和 Reasoning 三个版本,具备强大的代码生成、理解和推理能力。其最大亮点是采用“模型自助式”数据管道,利用大模型自动筛选和构建高质量训练数据,减少人工规则依赖。 -

豆包大模型1.5:字节跳动推出的新一代多模态AI大模型

豆包大模型1.5是字节跳动推出的新一代多模态AI大模型,涵盖多个版本,包括Doubao-1.5-pro、Doubao-1.5-lite、Doubao-1.5-vision-pro和实时语音模型。该模型在知识、代码、推理、中文等多个权威测评中表现优异,性能全球领先,适用于教育、开发和商业等多个领域。豆包大模型1.5采用稀疏MoE架构,优化推理效率,支持多模态和语音交互,推动AI技术创新与应用。 -

讯飞星火语音大模型

讯飞星火认知大模型是科大讯飞推出的AI大语言模型,专注于提供高精度的语音识别和超拟人化的语音合成服务。它支持多种语言和方言,具备自动语种判断和智能标点功能,能够实现流畅的语音转文字和自然口语的语音输出。该模型适用于语音搜索、聊天输入、游戏娱乐、人机交互、智能客服等多个场景,为企业和开发者提供了强大的语音交互解决方案。 -

Grok-2:xAI推出的新一代AI大模型

Grok-2 是由埃隆·马斯克旗下公司 xAI 推出的新一代AI模型,具备卓越的推理能力,并在聊天、编码和图像生成等多个领域表现优异。此次发布的版本包含 Grok 家族的两个成员:Grok-2 和 Grok-2 mini。目前,这两个模型已在 平台上面向Premium和Premium+用户进行测试。预计本月晚些时候,这两个模型还将通过企业API向开发者开放使用。 -

-

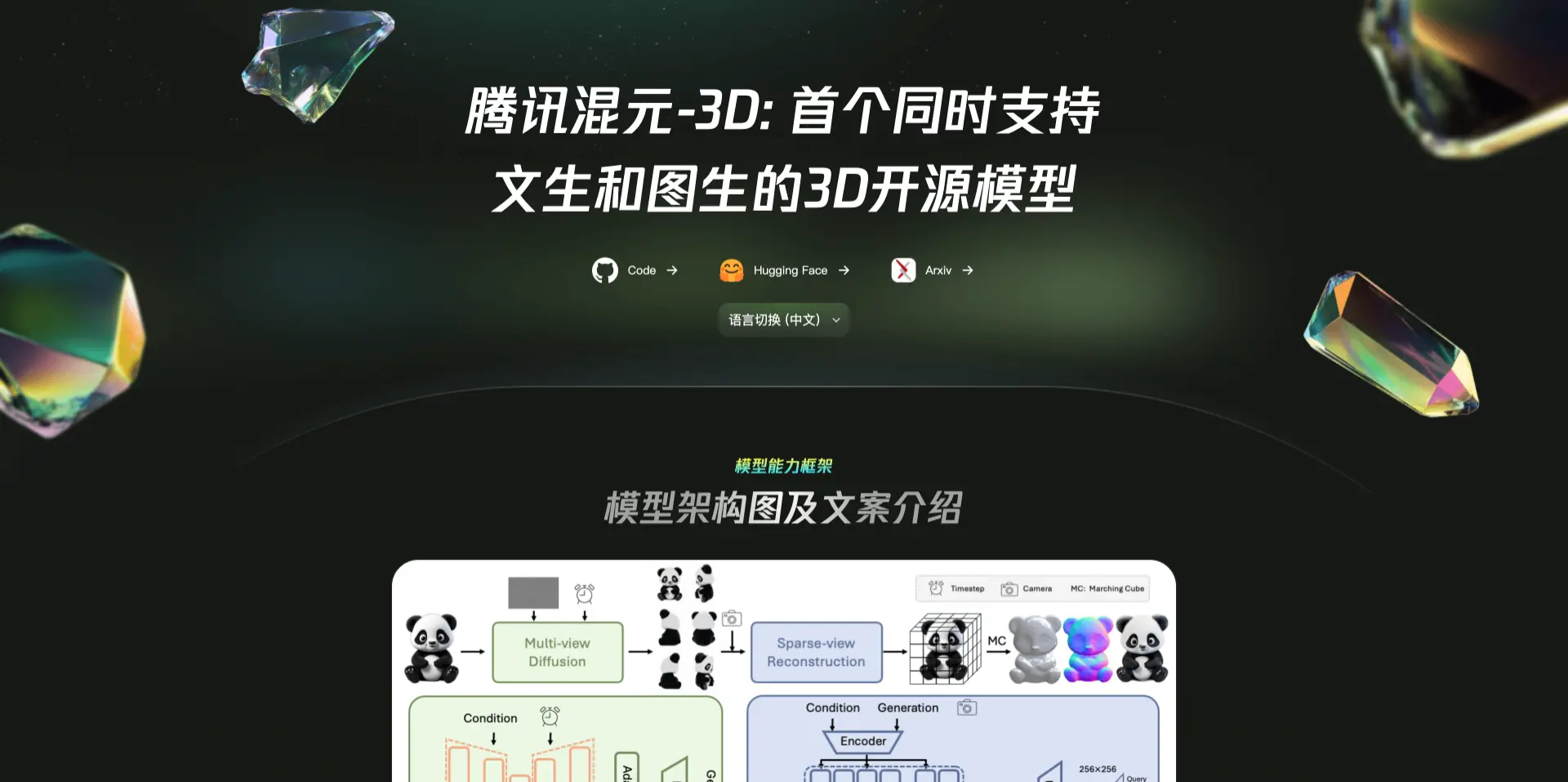

混元3D:腾讯混元发布的3D开源模型

腾讯混元3D:革新3D内容创作的AI引擎 腾讯混元3D是一款开源的大规模3D资产生成系统,通过文本或图像输入快速生成高分辨率且带纹理的3D模型。其核心采用两阶段生成流程:首先生成无纹理的几何模型,再合成高分辨率纹理贴图。这种解耦设计有效分离了形状与纹理生成的复杂性,同时支持对生成模型或手工模型的灵活纹理处理。 官网体验:https://3d.hunyuan.tencent.com/ 核心功能特性 … -

FLUX.1:Stable Diffusion原班人马推出的开源AI图像生成模型

FLUX.1是由Stable Diffusion原班人马推出的开源图像生成模型,在文字生成、复杂指令遵循和人手生成上具备优势。FLUX.1包含专业版、开发者版、快速版三种模型,其中前两款模型击败SD3-Ultra等主流模型,较小规模的FLUX.1[schnell]也超越了Midjourney v6.0、DALL·E 3等更大的模型。 -

-

QVQ-Max:阿里通义推出的视觉推理模型,能分析图片和视频内容

QVQ-Max 是阿里巴巴通义团队推出的AI视觉推理模型,能够分析图片和视频内容,进行推理和解决问题。它具备细致的观察能力,能识别图像中的关键元素,并结合背景知识进行深度推理。 -

Stable Virtual Camera:Stability AI等推出的AI模型 ,2D图像轻松转3D视频

Stable Virtual Camera是由Stability AI推出的多视图扩散模型,能够将2D图像转化为具有真实深度和透视效果的3D视频。该模型支持用户自定义相机轨迹和多种动态路径,可从单个或多达32个输入图像生成3D视频,并支持多种宽高比和长达1000帧的长视频生成。